Grundlagen Statistischer Auswertungsverfahren

Contents

- 1 Grundlagen statistischer Auswertungsverfahren

- 2 1. Funktion und Sinn von Statistik

- 3 1.1 Qualitative und Quantitative Forschungsmethoden - Gegensatz oder Ergänzung?

- 4 1.2 Formen der Statistik

- 5 1.3 Wahrscheinlichkeiten, nicht Gewissheit

- 6 2. Von der Fragestellung zur statistischen Analyse

- 7 2.1 Die Grundpopulation: worüber wir Aussagen machen

- 7.1 Elemente, Variable und Ausprägungen

- 7.2 Befragung der gesamten Grundpopulation nur selten möglich

- 7.3 Öffentliche Quellen für Daten über Grundpopulationen

- 7.4 2.1.1 Die Stichprobe (Sample)

- 7.5 2.1.2 Teil- oder Vollerhebung?

- 7.6 2.1.3 Die Ziehung (Auswahl) der Stichprobe

- 7.6.1 2.1.3.1 Geschichtete Stichprobenauswahl (Quotenstichprobe)

- 7.6.2 2.1.3.1.1 Proportional geschichtete Stichproben

- 7.6.3 2.1.3.1.2 Disproportional geschichtete Stichproben

- 7.6.4 2.1.3.1.3 Laufende Kontrolle der Schichtung

- 7.6.5 Während der Befragungsphase laufende Kontrolle der Schichtung erforderlich

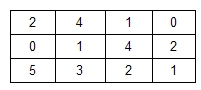

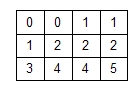

- 7.6.6 Berechnung

- 7.6.7 2.1.3.2 Zufallsstichproben

- 7.6.8 2.1.3.2.1 Einfache Zufallsstichprobe

- 7.6.9 2.1.3.2.2 Systematische Zufallsstichprobe

- 7.6.10 2.1.3.2.3 Geschichtete Zufallsstichprobe

- 7.6.11 2.1.3.3 Willkürliches Auswahlverfahren

- 7.6.12 2.1.3.4 Klumpenstichproben

- 7.7 2.1.4 Repräsentativität

- 7.8 2.1.5 Was tun, wenn die Grundpopulation nicht bekannt ist?

- 8 2.2 Die Operationalisierung

- 9 2.3 Gütekriterien quantitativer Untersuchungen

- 10 2.4 Fehlerquellen bei statistischer Arbeit

- 10.1 2.4.1 Fehler erster und zweiter Art

- 10.1.1 Hypothesen am Beginn der Untersuchung

- 10.1.2 Annahme oder Verwerfung von Hypothesen ist immer an Wahrscheinlichkeiten gebunden

- 10.1.3 Fehlerhafte Verwerfung bzw. Annahme von Hypothesen möglich

- 10.1.4 Mit der Zahl der statistischen Berechnungen steigt die Wahrscheinlichkeit von Fehlern der 1. oder 2. Art

- 10.1.5 Kontrolle durch qualitative Überlegungen erforderlich

- 10.2 2.4.2 Fehlerhafte oder mangelnde Daten

- 10.1 2.4.1 Fehler erster und zweiter Art

- 11 3. Ausgewählte statistische Grundlagen und Analysemethoden

- 12 3.1 Notwendiges Wissen für die Wahl geeigneter statistischer Analysemethoden

- 12.1 Analysemethoden sind abhängig von Datenart, -ausprägung, -anzahl und -verteilung:

- 12.2 Körpergrößen und Lieblingsobst

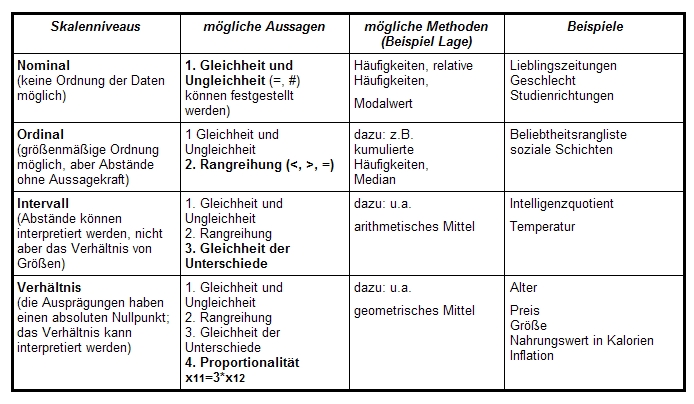

- 12.3 3.1.1 Arten von Messwerten (Daten)

- 12.4 3.1.2 Skalenniveaus

- 12.5 3.1.3 Verteilungen

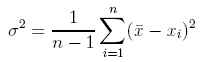

- 12.5.1 3.1.3.1 Normalverteilung

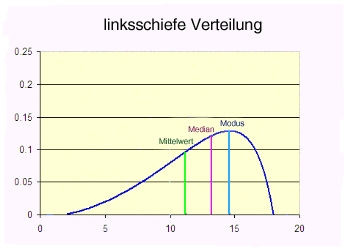

- 12.5.2 3.1.3.2 Andere Verteilungsformen

- 12.5.3 3.1.3.3 Test auf Normalverteilung

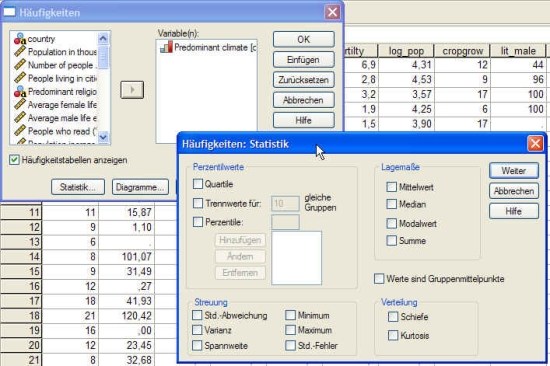

- 12.5.4 Erkennung mit SPSS

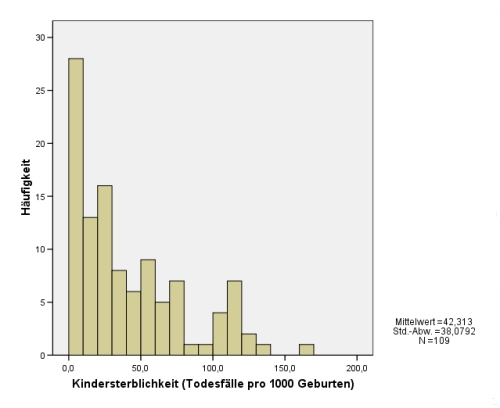

- 12.5.5 3.1.3.3.1 Optischer Nachweis einer Normalverteilung: das Histogramm

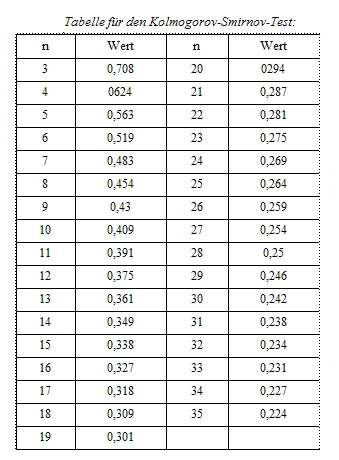

- 12.5.6 3.1.3.3.2 Nachweis der Normalverteilung: Kolmogorov-Smirnov-Test

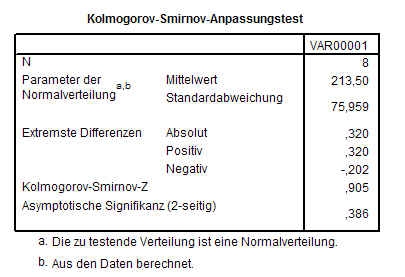

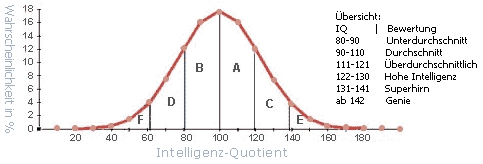

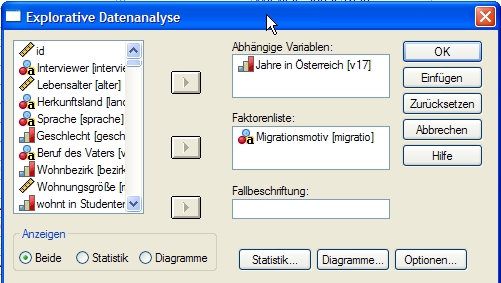

- 12.5.7 3.1.3.3.2.1 Kolmogorov-Smirnov-Test mit SPSS

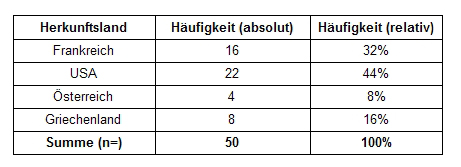

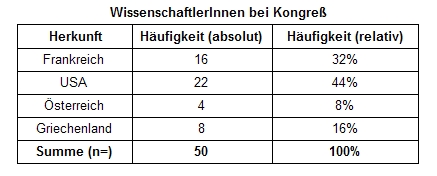

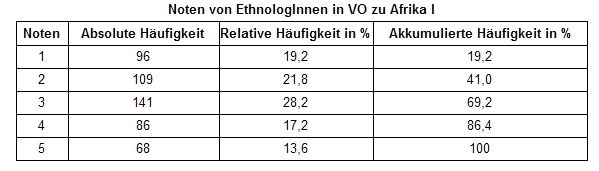

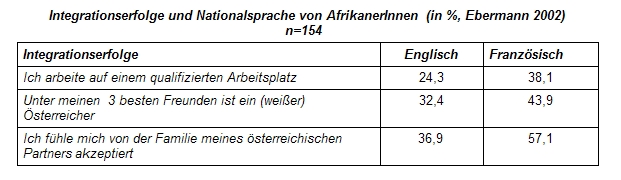

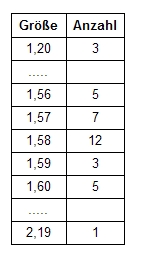

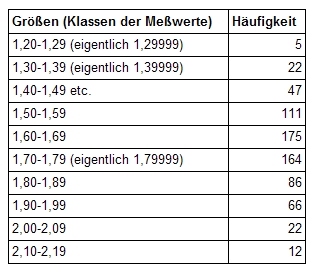

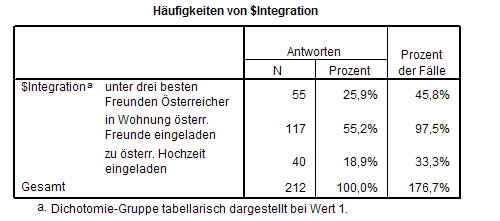

- 13 3.2 Die Ermittlung von Häufigkeiten

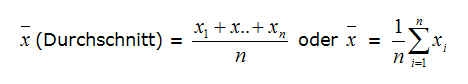

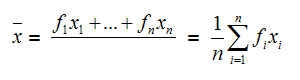

- 14 3.3 "Mittelwerte": Lagemaße und Maßzahlen der zentralen Tendenz

- 15 3.4 Streuungsmaße oder ’Wie allgemeingültig ist der Mittelwert’

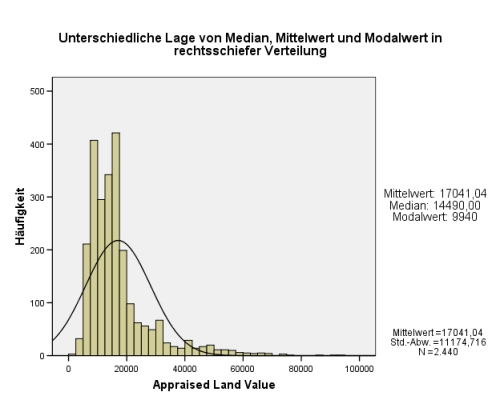

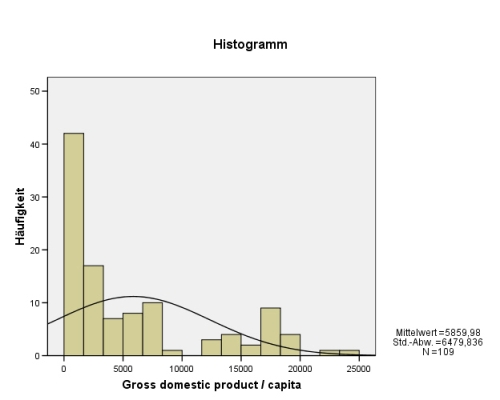

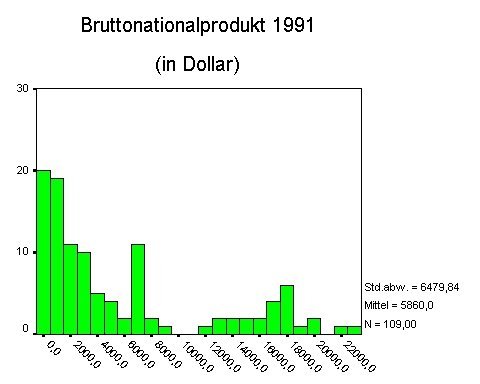

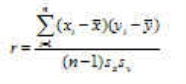

- 15.1 Grafische Darstellung der Streuung durch Histogramme

- 15.2 Lagemaße zeigen oft nur verzerrtes Bild der Realität bzw. Normalität

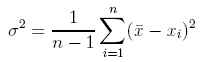

- 15.3 3.4.1 Varianz

- 15.4 3.4.2 Standardabweichung

- 15.5 3.4.3 Perzentile

- 15.6 3.4.4 Berechnung von Streuungsmaßen mit SPSS

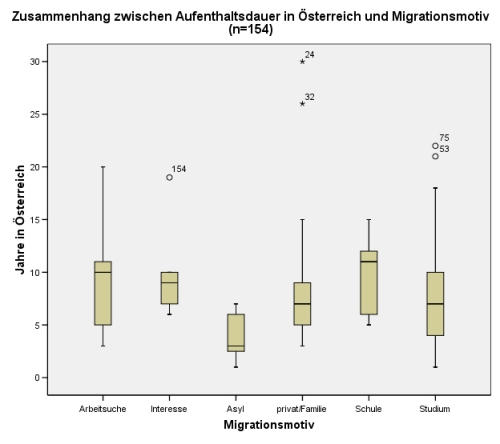

- 15.7 3.4.5 Vergleichende grafische Darstellung von Streuung und Lage mit Box-Plots

- 16 3.5 Der Zusammenhang zwischen Variablen

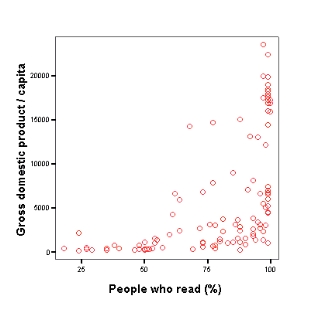

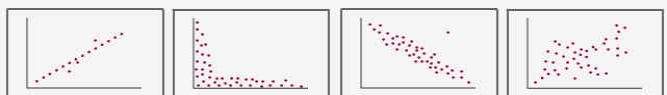

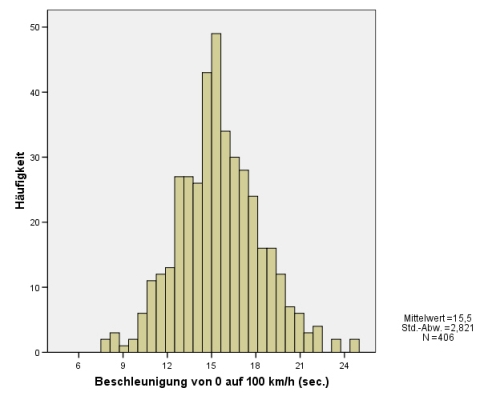

- 16.1 3.5.1 Optische Erkennung von Zusammenhängen

- 16.2 3.5.2 Kreuztabellen-Analyse

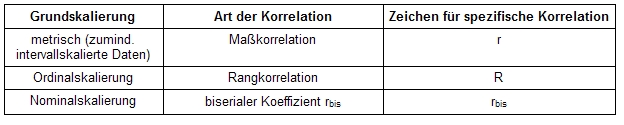

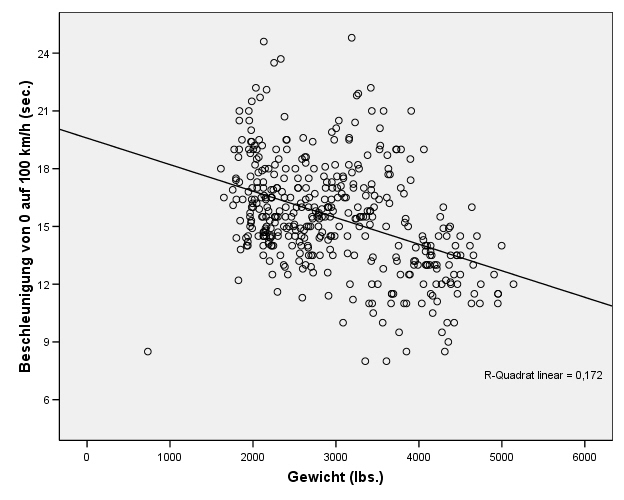

- 16.3 3.5.3 Die Korrelation

- 16.3.1 Vorsicht bei vorschneller Herstellung von Zusammenhängen

- 16.3.2 3.5.3.1 Maßkorrelation

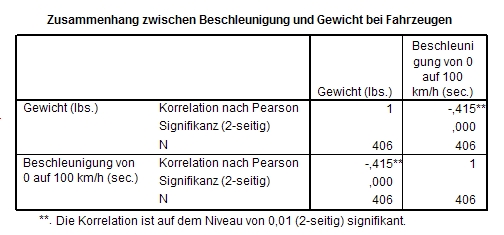

- 16.3.3 3.5.3.1.1 Berechnung der Maßkorrelation mit SPSS

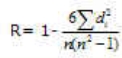

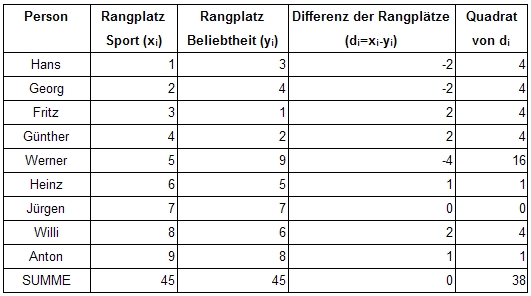

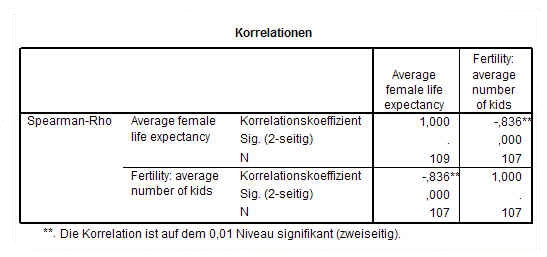

- 16.3.4 3.5.3.2 Rangkorrelation R (Krueger-Spearman)

- 16.3.5 3.5.3.2.1 Berechnung der Rangkorrelation mit SPSS

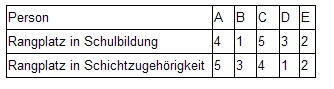

- 16.3.6 3.5.3.3 Rangkorrelation Tau (Kendall)

- 16.3.7 3.5.3.3.1 Berechnung von TAU mit SPSS

- 16.3.8 3.5.3.4 Aussagekraft einer Korrelation

- 16.3.9 3.5.3.4.1 Wann sind Korrelationen bemerkenswert?

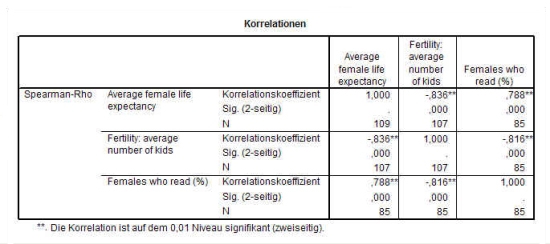

- 16.3.10 3.5.3.4.2 Verdeckte Korrelation

- 16.3.11 3.5.3.4.3 Scheinkorrelationen und Störvariable

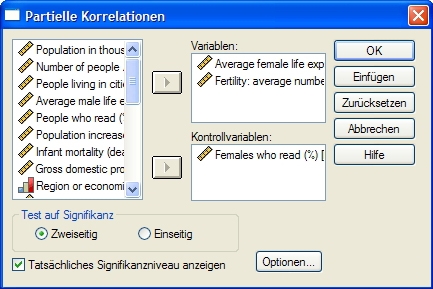

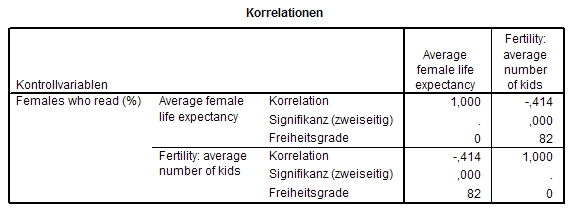

- 16.3.12 3.5.3.4.3.1 Partielle Korrelation mit SPSS

- 16.3.13 Beispiel: Korrelation von Fertiliät und weiblicher Lebenserwartung

- 16.3.14 3.5.3.4.4 Signifikanz der Korrelation

- 16.3.15 3.5.3.4.4.1 Signifikanz mit SPSS

- 16.3.16 3.5.3.5 Kovarianz

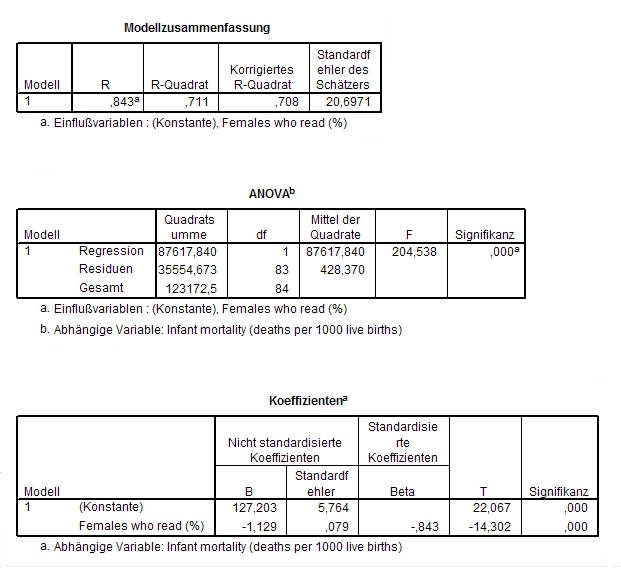

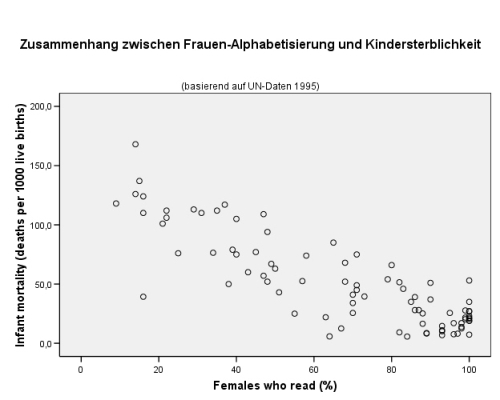

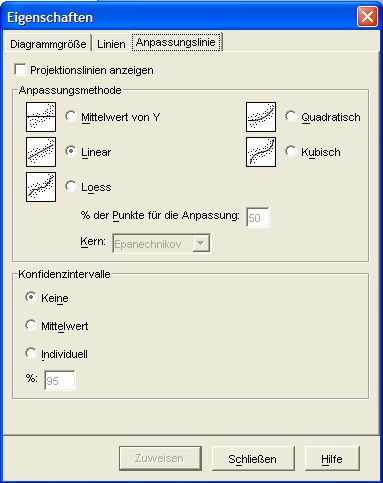

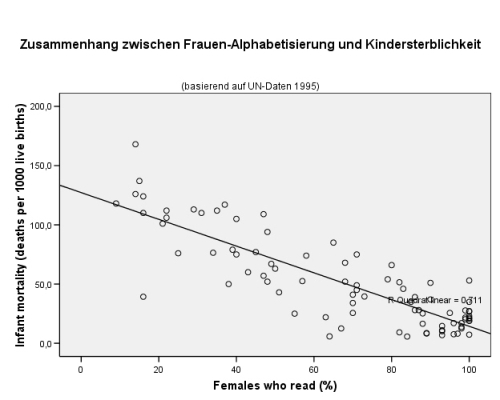

- 16.4 3.5.4 Regression

- 17 3.6 Die grafische Darstellung statistischer Ergebnisse

- 17.1 Ein Bild sagt mehr als 1000 Worte

- 17.2 Vorteil von Diagrammen liegt in Einfachheit der Darstellung

- 17.3 Nicht jedes Diagramm ist für jede Datenlage geeignet.

- 17.4 Begleitinformationen sind wichtig

- 17.5 Was in Diagrammen, was im Text?

- 17.6 3.6.1 Arten von Diagrammen

- 17.6.1 Viele Programme ermöglichen die Erstellung von Diagrammen

- 17.6.2 3.6.1.1 Kreisdiagramme

- 17.6.3 Besonders gut geeignet für die Darstellung relativer Anteile sind Torten- oder Kreisdiagramme:

- 17.6.4 3.6.1.2 Liniendiagramme

- 17.6.5 3.6.1.3 Balkendiagramme

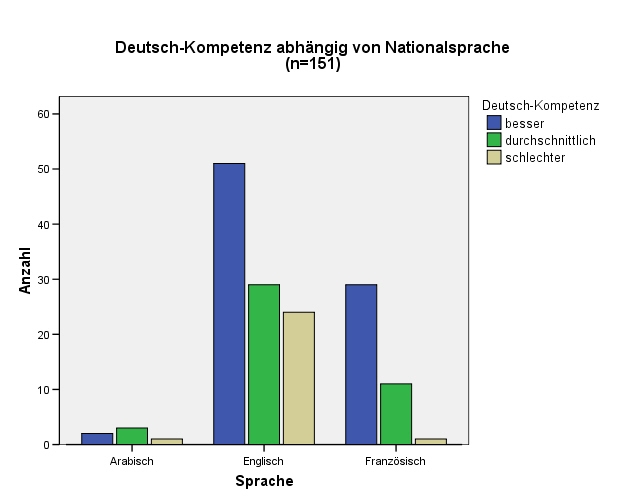

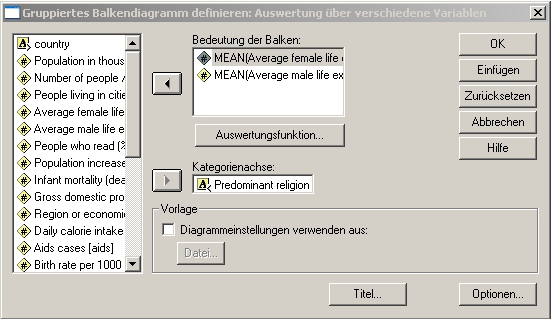

- 17.6.6 3.6.1.3.1 Gruppierte Balkendiagramme mit SPSS

- 17.6.7 3.6.1.4 Kartogramme

- 17.6.8 Kartogramme in Wahlanalysen häufig

- 17.6.9 3.6.1.5 Histogramme

- 17.6.10 3.6.1.6 Streudiagramme

- 17.7 3.6.2 Welches Diagramm für welche Daten?

- 17.8 3.6.3 Notwendige Begleitinformationen von Diagrammen

- 18 4. Software für quantitative Forschungsprojekte

- 19 4.1 Was kann Excel?

- 20 4.2 Was kann MS Access?

- 21 4.3 Profi-Programme: SPSS und Statistica

- 22 4.4 Datentransfer zwischen Programmen: Von Excel und Access zu SPSS

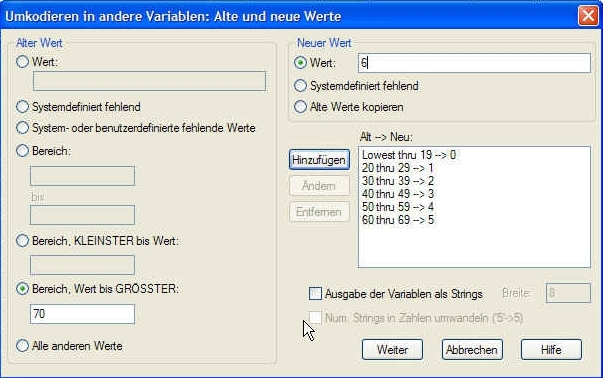

- 23 4.5 Umcodierung

- 24 5. Lexikon statistischer Grundbegriffe

- 25 5.1 A-C

- 25.1 Abhängige Variable

- 25.2 Alpha-Fehler

- 25.3 Alternativhypothese

- 25.4 Analytische Statistik (auch Schließende Statistik oder Inferenzstatistik)

- 25.5 Arithmetisches Mittel (oder Durchschnitt/-swert)

- 25.6 Balkendiagramm (auch Säulen- oder Blockdiagramm)

- 25.7 Bestimmtheitsmaß (auch Determinationskoeffizient)

- 26 5.2 D-F

- 27 5.3 G-I

- 28 5.4 J-M

- 28.1 Klasse

- 28.2 Klassifizerung (auch Klassierung).

- 28.3 Konfidenzinterall (auch Vertrauensintervall)

- 28.4 Kreisdiagramm (oder Tortendiagramm)

- 28.5 Kreuztabelle (auch Kontingenztabelle, -tafel)

- 28.6 Kumulative Häufigkeit (auch kumulierte H.)

- 28.7 Lagemaße (auch Zentralwerte oder Maße der zentralen Tendenz)

- 28.8 Liniendiagramm (auch Kurvendiagramm)

- 28.9 Median (auch Zentralwert)

- 28.10 Merkmal (auch Variable)

- 28.11 Messniveau (auch Skalenniveau)

- 28.12 Mittelwert (auch Arithmetisches Mittel)

- 28.13 Modalwert (auch Modus)

- 28.14 Modus (siehe Modalwert)

- 28.15 Multivariate Verfahren (oder m. Analyse)

- 29 5.5 N-P

- 29.1 Nichtparametrische Verfahren (auch parameterfreie Verfahren)

- 29.2 Normalverteilung (auch Gaußverteilung)

- 29.3 p-Wert (auch Überschreitungswahrscheinlichkeit)

- 29.4 Partielle Korrelation (auch Partialkorrelation)

- 29.5 Proportionalskala (auch Verhältnisskala)

- 29.6 Produkt-Moment-Korrelation (auch Pearson’scher Korrelationskoeffizient)

- 30 5.6 Q-R

- 31 5.7 S-T

- 31.1 Säulendiagramm

- 31.2 Schichtung

- 31.3 Schließende Statistik

- 31.4 Selektion

- 31.5 Signifikanz

- 31.6 Signifianzniveau

- 31.7 Skala

- 31.8 Skalenniveau

- 31.9 Spannweite

- 31.10 Spearman’s Rho (oder Spearmans Korrelationskoeffizient)

- 31.11 Störvariable (oder Störgrößen)

- 31.12 Streudiagramm (auch Scatterplot)

- 31.13 Streuungsmaße (auch Dispersionsmaße)

- 31.14 Tau (auch Kendall’s Tau)

- 32 5.8 U-Z

- 33 6. Literatur, Ressourcen und Links

- 34 6.1 Quantitative Forschungsmethoden

- 35 6.2 Fragebogen-Abfrage

- 36 6.3 Methoden

- 37 6.4 Repräsentativität

- 38 6.5 Statistik-Software

- 39 6.6 Terminologie

- 40 6.7 Statistik-Quellen

Grundlagen statistischer Auswertungsverfahren

Quelle: http://www.univie.ac.at/ksa/elearning/cp/quantitative/quantitative-titel.html

Erwin Ebermann

Institut für Kultur- und Sozialanthropologie

Kapitelübersicht

1. Funktion und Sinn von Statistik

- 1.1 Qualitative und Quantitative Forschungsmethoden - Gegensatz oder Ergänzung?

- 1.2 Formen der Statistik

2. Von der Fragestellung zur statistischen Analyse

- 2.1 Die Grundpopulation: worüber wir Aussagen machen

- 2.1.1 Die Stichprobe (Sample)

- 2.1.2 Teil- oder Vollerhebung?

- 2.1.3 Die Ziehung (Auswahl) der Stichprobe

- 2.1.4 Repräsentativität

- 2.1.5 Was tun, wenn die Grundpopulation nicht bekannt ist?

- 2.1.1 Die Stichprobe (Sample)

- 2.2 Die Operationalisierung

- 2.3 Gütekriterien quantitativer Untersuchungen

- 2.4 Fehlerquellen bei statistischer Arbeit

3. Ausgewählte statistische Grundlagen und Analysemethoden

- 3.1 Notwendiges Wissen für die Wahl geeigneter statistischer Analysemethoden

- 3.2 Die Ermittlung von Häufigkeiten

- 3.3 "Mittelwerte": Lagemaße und Maßzahlen der zentralen Tendenz

- 3.4 Streuungsmaße oder ’Wie allgemeingültig ist der Mittelwert’

- 3.5 Der Zusammenhang zwischen Variablen

- 3.6 Die grafische Darstellung statistischer Ergebnisse

4. Software für quantitative Forschungsprojekte

- 4.1 Was kann Excel?

- 4.2 Was kann MS Access?

- 4.3 Profi-Programme: SPSS und Statistica

- 4.4 Datentransfer zwischen Programmen: Von Excel und Access zu SPSS

- 4.5 Umcodierung

\[(.*)\] Siehe Kapitel

1. Funktion und Sinn von Statistik

Weitverbreitete Scheu vor statistischen Methoden

Was bringt Statistik, was bringen quantitative Forschungsmethoden? Viele Menschen stehen ihnen skeptisch gegenüber und dies teilweise leider zurecht. Allzuleicht kann mit Statistiken Unfug getrieben werden und nicht immer sind die BetrachterInnen statistisch aufbereiteter Daten genügend geschult, um bewusste Verzerrungen zu erkennen. Richtig verwendet jedoch, ist die Statistik ein unverzichtbares Hilfsmittel, um - losgelöst von der subjektiven Wahrnehmung - die Systematik von Tendenzen und Zusammenhängen in verschiedensten Lebensbereichen aufzeigen zu können.

Statistik in der Alltagserfahrung

Ob wir wollen oder nicht, auch wenn wir niemals etwas von Statistik gehört haben, so wenden wir dennoch meist unreflektiert und unsystematisch Methoden an, welche statistischen Verfahren ähneln. D.h. wir versuchen, von einem begrenzten Erfahrungsschatz auf allgemeine Sachverhalte zu schließen. Jede Erfahrung, die wir machen, beeinflusst mit einer gewissen Wahrscheinlichkeit unsere zukünftigen Handlungs- und Denkweisen. Wir vermeiden vielleicht den Kontakt mit bestimmten Gruppen der Gesellschaft, weil sie uns wenig kooperativ erscheinen; wir fällen aufgrund einzelner Geschehnisse verallgemeinernde Urteile über Bekannte, dass sie diese oder jene Eigenschaft aufweisen, über Menschen, welche in der Öffentlichkeit stehen, über den öffentlichen Verkehr:

Ilse ist äußerst hilfsbereit!

Mit Georg kann man darüber nicht sprechen!

Die 5er-Linie kommt immer verspätet!

Immer wenn das Wochenende kommt, regnet es!

Alle diese Aussagen basieren auf dem in der Statistik gängigen Vorgang, von einer begrenzten Erfahrung bzw. von einem begrenzten Datenschatz auf alle möglichen Erfahrungen bzw. Daten hochzurechnen, wobei wir bei diesen Aussagen jedoch wichtige Grundprinzipien der Statistik nicht berücksichtigen. Diese ’unbewussten’ Anwendungen statistischer Prinzipien ähneln den Versuchen von Couchpotatoes, die Fussballkünste eines Ronaldinho in der Praxis nachzuvollziehen.

Häufige Fehler bei der ’unbewussten’ Verwendung statistischer Methoden

Wir möchten mit diesen Aussagen ausdrücken, dass bestimmte Grundtendenzen vorkommen, dass diese systematisch sind. Aber sind sie das? Haben wir die Rahmbendingungen genügend beachtet? Ist Georg vielleicht nur mir gegenüber nicht gesprächsbereit? Gilt Ilse vielleicht allen anderen gegenüber als schroff und unkooperativ? Kommt die 5er-Linie nur zu bestimmten Tageszeiten, an welchen gerade ich sie immer benutze, zu spät und zu anderen Zeitpunkten pünktlich? Nehme ich schlechtes Wetter unter der Woche gar nicht wahr, weil ich mich im Büro befinde? Stimmt mein eigener Eindruck oder beharre ich auf meinem allerersten und möchte neue Erfahrungen nicht wahrnehmen?

Statistik muss mit Sorgfalt eingesetzt werden

Die Statistik gibt uns Methoden in die Hand, Vorurteile kritischer zu beleuchten und die Wahrscheinlichkeit[1] scheinbaren Wissens zu beurteilen, falls sie mit Verantwortungsbewusstsein und Sorgfalt verwendet werden. Sie ist besonders dann von großer Bedeutung, wenn wir - losgelöst von singulären Ereignissen oder Elementen - allgemeine Aussagen machen möchten. Sie ist dementsprechend kein Gegensatz zu qualitativen Forschungsmethoden, sondern eine unverzichtbare Ergänzung[2] zu diesen.

Verweise:

[1] Siehe Kapitel 1.3

[2] &&& http://www.univie.ac.at/ksa/elearning/cp/qualitative/qualitative-50.html

1.1 Qualitative und Quantitative Forschungsmethoden - Gegensatz oder Ergänzung?

Quantitative und qualitative Forschungsmethoden haben unterschiedliche Potentiale und Möglichkeiten und sind dementsprechend kein Gegensatz, sondern ergänzen sich gegenseitig.

Häufig Misstrauen gegenüber Statistik in Geistes- und Kulturwissenschaften

In den Wissenschaften vom Menschen, wie z.B. der Sozial- und Kulturanthropologie, sind qualitative Forschungsmethoden[1] meist deutlich populärer als quantitative. Es mutet zu nüchtern an, zu festschreibend, zu klischeehaft, Menschen durch eine Reihe von meist kurzen Indikatoren beschreiben[2] zu wollen. GestaltpsychologInnen würden formulieren: "Das Ganze ist mehr als die Summe seiner Einzelteile."

Zur Tiefe benötigt man qualitative Ansätze

Und sie haben in Vielem zweifellos recht. Wir benötigen in der Regel qualitative Methoden, um feingewobene Motivforschung zu betreiben, um versteckte Aspirationen, Einstellungen, Eigenheiten zum Vorschein zu bringen. Wie könnte ein kurzer Fragebogen von einer halben Stunde Dauer das gleiche Wissen über die gleiche Person zum Vorschein bringen wie eine Befragung über mehrere Tage, die noch dazu weitgehend dem Rythmus des/der Befragten folgt? Das geht nicht. Und ginge es nur um die Befragung und Eigenheiten einzelner Individuen, etwa um eine Biographie, benötigen wir die Quantitativen Forschungsmethoden eigentlich gar nicht.

Von der Tiefe zur Breite

Nehmen wir nun aber an, jemand hätte mit großer Sensiblität und Mühe aus zehn Personen sehr viel zum Vorschein gebracht, an Ängsten, Erwarungshaltungen, biographischen Daten, an Erfahrungen, Einstellungen usw. Nehmen wir an, alle zehn Befragten wären AfrikanerInnen gewesen. Könnten wir ihm/ihr nun die Frage stellen, uns zu sagen, wo AfrikanerInnen Elemente des Lebens anders wahrnehmen, anders reagieren, anders geprägt sind? Er/Sie könnte mit einem rein qualitativen Ansatz darauf keine Antwort geben. Er/Sie könnte nur antworten: "Die meisten der befragten zehn Personen sind wegen der Suche nach Arbeit nach Österreich gekommen. Die Hälfte von ihnen empfindet ein größeres Maß von Einsamkeit etc." Jede Aussage über Tendenzen der größeren Gruppe, zu der die Befragten gehören, wäre vermessen. Wie soll man wissen, ob die zehn Befragten nicht vielleicht die einzigen in der afrikanischen Community sind, die bestimmte Eigenschaften aufweisen, vielleicht auch die einzigen, welche überhaupt bereit sind, mit den weißen ForscherInnen darüber zu sprechen?

Qualitative und quantitative Methoden ergänzen und erfordern einander

An dieser Stelle werden quantitative Forschungsmethoden als Ergänzung[3] zu den qualitativen unverzichtbar. Beim quantitativen Untersuchungsansatz würde man mit geeigneten Methoden versuchen, die Befragten[4] bereits so auszuwählen, dass sie in den wesentlichen Bereichen ein realistisches Abbild der hier lebenden afrikanischen Community bilden.

Tiefe durch qualitative, Breite durch quantitative Methoden

Quantitative Forschungsmethoden folgen oft qualitativen. Qualitative Untersuchungen liefern hochinteressante Informationen über Menschen, die zu einer bestimmten Berufsgruppe, Region oder Kultur gehören. In von Oralliteratur geprägten Regionen werden z.B. viele Bereiche einer häufigeren Neuinterpretation unterliegen, da mit der schriftlichen Fixierung oft auch eine erhöhte Stabilisierung eines Sachverhalts einhergeht. Zu Randbereichen mag es daher eine Fülle von Interpretationen geben. So mag ein Informant Gedanken äußern, welche erstaunliche Ähnlichkeit mit Reinkarnationsphilosophien anderer Weltgegenden aufweisen. Nun wird es - falls es ums Weltbild der betreffenden Kultur geht - wichtig sein, zu klären, ob nur diese Person oder die ganze Gesellschaft an das Phänomen der Reinkarnation glaubt. Nun könnte man mit einer kleinen quantitativen Erhebung, bei der die verschiedenen Gruppen der Gesellschaft befragt werden, schnell herausfinden, ob für diese Vorstellung die Biographie des Individuums (wie z.B. auf Reisen durch Kontakt mit anderen Völkern erworben), die Prägung einer Kaste innerhalb des Volkes oder die Prägung der ganzen Bevölkerung verantwortlich ist. Und dann könnte man eine allgemeinere Aussage über diesen Sachverhalt machen: "In diesem Volk glauben nur die Älteren an die Reinkarnation, die Jüngeren haben vorwiegend das christliche oder islamische Modell übernommen etc.".

Verweise:

[1] &&& http://www.univie.ac.at/ksa/elearning/cp/qualitative/qualitative-titel.html

[2] &&& http://www.univie.ac.at/ksa/elearning/cp/schreiben/schreiben-2.html

[3] &&& http://www.univie.ac.at/ksa/elearning/cp/qualitative/qualitative-50.html

[4] Siehe Kapitel 2.1

1.2 Formen der Statistik

Man unterscheidet im wesentlichen zwei verschiedene Formen der Statistik:

- die deskriptive Statistik, bei der mit einfachen Maßzahlen und Grafiken Wesentliches über einen Untersuchungsgegenstand ausgedrückt werden soll, sowie

- die schließende oder analystische Statistik, die sich im wesentlichen die Frage stellt, inwieweit das Gemessene als Abbild der Realität geeignet ist.

Vergleich anhand der Einkommenssituation in Bangladesh

Nehmen wir an, wir untersuchen die Einkommensituation in zwei benachbarten Dörfern in Bangladesh. Wir stellen in den beiden Dörfern ein bestimmtes Durchschnittseinkommen fest und drücken dies in einer Maßzahl aus, z.B. dem Median[1] oder dem Mittelwert[2]. Mittels eines Balkendiagramms[3] zeigen wir auch optisch, dass das Durchschnitseinkommen von Dorf A höher ist als das von Dorf B. Bisher sind wir immer noch im Bereich der deskriptiven Statistik geblieben.

Wenn wir uns nun allerdings die Frage stellen, ob der von uns festgestellte Einkommensunterschied zwischen den beiden Dörfern zufälliger Natur oder hoch signifikant[4] ist, dann geraten wir mit den entsprechenden Methoden (z.B. dem T-Test (Wikipedia)[5]) in den Bereich der schließenden Statistik.

Verweise:

[1] Siehe Kapitel 3.3.3

[2] Siehe Kapitel 3.3.2

[3] Siehe Kapitel 3.6.1.3

[4] Siehe Kapitel 1.3.2

[5] http://de.wikipedia.org/wiki/T-Test

1.2.1 Deskriptive Statistik

Die deskriptive Statistik hat zum Ziel, die wesentlichen Eigenheiten eines Untersuchungsgegenstandes zusammenzufassen und in wenigen Maßzahlen bzw. Diagrammen klar und verständlich zu beschreiben.

Die Aussagen der deskriptiven Statistik beziehen sich dabei immer nur auf die untersuchte Stichprobe. Die Darstellungsformen liegen in Maßzahlen, in Grafiken[1] und Tabellen. Häufige Maßzahlen der deskriptiven Statistik sind z.B. Mittelwerte[2] oder die Streuung einer Stichprobe[3] oder deren grafische Entsprechungen in Form z.B. von Kreis- oder Stabdiagrammen[4].

Beispiel: Vergleichende Dorfstudien in Mali

Wir untersuchen zwei Siedlungen in Mali in Westafrika. Wir befragen jeweils 50 Personen aus den beiden Siedlungen zu Einschätzungen eines in der Gegend lebenden Volkes. Wir halten nüchtern fest, wie diese Einschätzungen ausfallen. Wir können dann z.B. angeben, dass das rinderzüchtende Volk der Fulbe in Nkorongoji relativ negativ betrachtet wird, in der Stadt Kita hingegen eher positiv. Das sind nüchterne Beschreibungen = Deskriptionen.

Bei der deskriptiven Statistik untersuchen wir nicht, ob diese Unterschiede der Einschätzungen der Fulbe möglicherweise zufälliger Natur sein könnten (weil die Stichproben[5] zu klein waren; die Einschätzungsabstände zu klein; weil wir durch viel Pech trotz sorgfältiger Auswahl der Befragten im Ort Nkorongoji gerade an die Personengruppen geraten sind, welche aus historischen Gründen Fulbe negativ gegenüber stehen, während die Mehrheit eher positiv denkt usw.). Die Untersuchung der Wahrscheinlichkeit[6] der Unterschiede gehört zur Analytischen Statistik.

Verweise:

[1] Siehe Kapitel 3.6

[2] Siehe Kapitel 3.3

[3] Siehe Kapitel 3.4

[4] Siehe Kapitel 3.6.1

[5] Siehe Kapitel 2.1.1

[6] Siehe Kapitel 1.3

1.2.2 Analytische Statistik

Die analytische (auch schließende oder deduktive[1] genannt) Statistik beschäftigt sich im Wesentlichen mit der Frage der Zufälligkeit statistisch gemessener Phänomene. So stellt man sich die Frage, inwieweit ein in einer Stichprobe gemessener Mittelwert[2] vom Mittelwert der Grundgesamtheit[3] abweichen[4] könnte; man stellt sich bei verschiedenen Stichproben die Frage, ob sie angesichts ihrer gemessenen Unterschiede noch zur gleichen Grundgesamtheit gehören können u.a. Hier wird also versucht, die untersuchte Stichprobe in einem größeren Ganzen einzuordnen, wobei auch der Untersuchung der Wahrscheinlichkeit von Zusammenhängen[5] bzw. Differenzen breiter Raum eingeräumt wird.

Beispiel 1: Sind Unterschiede (über-)zufällig?

In einem Ort A findet man bei 50 Befragten ein Durchschnittseinkommen von € 1300 ermittelt, im Ort B bei einer gleich großen Stichprobe[6] ein Durchschnittseinkommen von € 1765. Mit Methoden der analytischen Statistik könnten wir herausfinden, ob der Einkommensunterschied zwischen diesen beiden Stichproben die Verallgemeinerung erlaubt, dass die Bevölkerungen der beiden Orte tatsächlich unterschiedlich gut verdienen oder ob der gemessene Unterschied rein zufälliger Natur[7] sein könnte (weil die Befragten sich trotz aller Sorgfalt bei ihrer Auswahl gerade an diesem Punkt von ihren MitbewohnerInnen unterscheiden).

Beispiel 2: Ist ein gemessenes Ergebnis noch ’normal’?

Normalerweise sollten beim Roulette-Spiel in einem längeren Untersuchungszeitraum alle 37 Zahlen etwa gleich häufig auftreten. In einem Spielcasino kamen im Untersuchungszeitraum am Roulette-Tisch verschiedene Zahlen deutlich häufiger als andere vor. Mit den geeigneten (analytischen) Methoden der Wahrscheinlichkeitsrechnung ermittelt man, ob der Roulette-Tisch möglicherweise einseitig so beschaffen oder abgenützt ist, dass man wahrscheinlich auf Dauer mit unterschiedlichen Häufigkeiten rechnen muss oder ob die gemessenen Ergebnisse rein zufälliger Natur waren.

Verweise:

[1] &&& http://www.univie.ac.at/ksa/elearning/cp/qualitative/qualitative-6.html

[2] Siehe Kapitel 3.3

[3] Siehe Kapitel 2.1

[4] Siehe Kapitel 1.3.1

[5] Siehe Kapitel 3.5

[6] Siehe Kapitel 2.1.1

[7] Siehe Kapitel 1.3.2

1.3 Wahrscheinlichkeiten, nicht Gewissheit

(Analytische) Statistik nimmt Wahrscheinlichkeiten an, nicht Gewissheiten.

In der Statistik beschreiben und analysieren wir meist Stichproben[1], also eine Auswahl einer Grundgesamtheit. Dabei ist immer damit zu rechnen, dass sich auch eine sorgfältig zusammengesetzte Stichprobe in wesentlichen Parametern von der Grundgesamtheit[2] unterscheidet, sie also nicht wiederspiegelt.

Wenn wir z.B. 100 Mitmenschen zu ihren Wahlpräferenzen befragen, dann kann es sein, dass die Beliebtheit der SPÖ bei ihnen deutlich anders ausfällt als bei der Grundgesamtheit, auch wenn aus der Schichtung der Stichprobe keinerlei tendenziöse Verteilung der Personen ersichtlich war.

Konfidenzintervalle

Besonders in der analytischen Statistik gibt man daher Konfidenzintervalle bzw. Schwankungsbreiten an, innerhalb derer sich ein wahrer Wert bewegen soll, d.h. der vermutete Wert in der Grundpopulation. Die Breite der Konfidenzintervalle hängt von der Größe der Stichprobe, deren relativer Größe im Verhältnis zur Grundpopulation sowie von der gewählten Irrtumswahrscheinlichkeit ab.

Beispiel Hochrechnung am Wahlsonntag:

Wir erleben dies immer am Wahlsonntag, wenn gegen 17h zum Zeitpunkt der 1. Hochrechnung die Statistikexperten angeben, dass die Partei A mit zwischen 35,3 und 36,8% der Stimmen zu rechnen hat, Partei B etc.

Verweise:

[1] Siehe Kapitel 2.1.1

[2] Siehe Kapitel 2.1

1.3.1 Schwankungsbreiten und Konfidenzintervalle

Unter Schwankungsbreite bzw. Konfidenzintervall versteht man einen Bereich, innerhalb dessen eine Merkmalsausprägung für die Grundpopulation bei einer festgesetzten Irrtumswahrscheinlichkeit angenommen wird, wobei der für die Schätzung verwendete Ausgangswert aus einer Stichprobe ermittelt wurde.

Die Schwankungsbreite oder das Konfidenzintervall hängen von folgenden Faktoren ab:

a. dem gewählten Signifikanzniveau (je signifikanter, dester größer die Schwankungsbreite);

b. dem größenmäßigen Verhältnis zwischen Stichprobe und Grundpopulation[1] (je größer der Unterschied, desto größer die Wahrscheinlichkeit, dass die Ergebnisse voneinander abweichen und damit die Schwankungsbreite);

c. der Größe der Stichprobe[2] (je kleiner, desto größer ist die Schwankungsbreite)

Beispiel zu Punkt b am Wahlabend:

Während die StatistikerInnen gegen 17 h bei vielleicht 10 % der ausgezählten Stimmen die Schwankungsbreite der Stimmen für Partei A mit zwischen 35,3 bis 36,8 angeben (also einer Spanne von 1,5 %), wird gegen 19 h, wenn etwa 90 % der Stimmen ausgezählt sind, eine Schwankungsbreite von vielleicht 0,2 oder 0,3 % angegeben werden, also 35,9-36,2 %).

Siehe auch Konfidenzintervall (Wikipedia)[3].

Verweise:

[1] Siehe Kapitel 2.1

[2] Siehe Kapitel 2.1.1

[3] http://de.wikipedia.org/wiki/Konfidenzintervall

1.3.2 Irrtumswahrscheinlichkeit und Signifikanzniveau

Unter der Irrtumswahrscheinlichkeit p versteht man die zahlenmäßig ausgedrückte Wahrscheinlichkeit, dass sich ein Ergebnis einer statistischen Analyse substantiell vom tatsächlichen Ergebnis der Grundpopulation unterscheidet.

In der Statistik arbeitet man meist mit den drei folgenden Signifikanzniveaus oder -grenzen:

p ≤ 0,05: signifikant (Irrtumswahrscheinlichkeit kleiner als 5 %)

p ≤ 0,01: sehr signifikant (Irrrtumswahrscheinlichkeit kleiner als 1 %)

p ≤ 0,001: höchst signifikant (Irrtumswahrscheinlichkeit kleiner als 1 ‰)

Wenn daher bei einer Hochrechnung am Wahlabend gesagt wird, dass bei einer Irrtumswahrscheinlichkeit von weniger als 1 % eine Partei zwischen 35,2 und 35,6 % der Stimmen erhalten wird, dann bedeutet dies, dass nur in weniger als 1% aller Fälle das tatsächliche Endergebnis außerhalb dieses Bereiches liegen wird.

Siehe auch Signifikanz (Wikipedia)[1].

Verweise:

[1] http://de.wikipedia.org/wiki/Statistische_Signifikanz

2. Von der Fragestellung zur statistischen Analyse

Wesentliche Elemente bei quantitativen Forschungsansätzen

Bei quantitativen Forschungsansätzen sind die folgenden Teilbereiche von besonderer Bedeutung:

- die Untersuchungsobjekte, über welche wir eine Aussage machen möchten (z.B. LateinamerikanerInnen in Wien);

- die Forschungsfrage, die wir mit den Untersuchungsobjekten verbinden (z.B. ihre Erfahrungen in Wien)

- die Operationalisierung, d.h. die Art und Weise, wie wir Einstellungen und Sachverhalte messen

Interessiert uns z.B. die Einstellung der lokalen Bevölkerung zur Entwicklungszusammenarbeit, dann ist das zu untersuchende Objekt die Bevölkerung (die Grundpopulation), während die thematischen Fragen die Einstellungen der Bevölkerung zur EZA darstellen.

Befragung der richtigen Personen mit den richtigen/relevanten Fragen

Wir müssen sowohl sicherstellen, dass wir uns tatsächlich bei unseren Befragungen an diese Grundpopulation wenden (siehe dazu auch Grundpopulation und Repräsentativität[1]), als auch, dass die thematischen Fragen in eindeutiger Weise beantwortet werden können, die eine statistische Interpretation ermöglichen (siehe Operationalisierung[2] und Messen[3]).

Im oben genannten Beispiel müssen wir also genau abklären, wer oder was die lokale Bevölkerung ist, wie sie sich differenziert (Objekt) und zusätzlich eine Reihe von thematischen Fragestellungen entwickeln, deren Gesamtheit es erlaubt, die Einstellung von Menschen zur Entwicklungszusammenarbeit einzuschätzen (wie z.B. prinzipielle Zustimmung bzw. Ablehnung der EZA; Frage nach privaten Spenden oder anderen Aktivitäten für diesen Bereich; Fragen nach der bevorzugten Art der EZA; Frage nach der Akzeptanz von Transfair-Produkten; Fragen nach der gewünschten Höhe der EZA-Leistungen; Fragen nach Ländern und Regionen, die als förderungswürdig gelten usw.).

Verweise:

[1] Siehe Kapitel 2.1.4

[2] Siehe Kapitel 2.2

[3] Siehe Kapitel 2.2.2

2.1 Die Grundpopulation: worüber wir Aussagen machen

Die empirische Grundgesamtheit (Grundpopulation) ist jene abgegrenzte Menge von Personen (z.B. die Wiener Bevölkerung) oder Objekten (z.B. die Regenfälle in einer tropischen Region, die Autos im 7. Bezirk), über die man Aussagen machen möchte.

Anders ausgedrückt: Wenn wir eine Studie zu AfrikanerInnen in Österreich durchführen, dann möchten wir als Ergebnis zu Aussagen kommen, welche Tendenzen sich in dieser Bevölkerungsgruppe zeigen. Alle Mitglieder der Gruppe AfrikanerInnen in Österreich bilden gemeinsam die Grundgesamtheit.

Elemente, Variable und Ausprägungen

Ein Einzelobjekt aus dieser Grundgesamtheit bezeichnet man als statistische Einheit oder Element (z.B. Herr Moussa Bamba aus Bamako, der jetzt in Wien lebt). Die Einzelobjekte weisen jeweils Merkmale auf (auch Variablen genannt, z.B. Geschlecht, Einkommen, Autofarbe etc.), die uns interessieren und über deren Ausprägung in der Grundgesamtheit wir mehr erfahren möchten (die sogenannte Verteilung[1]). Die möglichen Werte dieser Merkmale bezeichnet man als Merkmalsausprägungen. So gibt es für das Merkmal Geschlecht die Ausprägungen männlich oder weiblich, für die Variable Körpergröße Zahlen zwischen theoretisch Null und deutlich über zwei Meter.

Befragung der gesamten Grundpopulation nur selten möglich

Meist ist die Grundpopulation so groß, dass wir nur einen Teil der Grundpopulation befragen können, eine sogenannte Stichprobe.

Öffentliche Quellen für Daten über Grundpopulationen

Grundinformationen über die Verteilung der Grundpopulationen kann man u.a. suchen bei Statistik Austria[2] und anderen Informationsstellen, in einschlägigen Publikationen etc.

Verweise:

[1] Siehe Kapitel 3.1.3

[2] http://www.statistik.at/

2.1.1 Die Stichprobe (Sample)

Eine Stichprobe ist eine Auswahl von Elementen der Grundgesamtheit, anhand derer die Grundgesamtheit[1] nachgebildet werden soll.

Auswahl fast immer notwendig

Auf Grund der Größe der Grundpopulationen ist es kaum jemals möglich, alle Mitglieder derselben zu befragen. Daher greift man in der Regel zu Stichproben, also einer Auswahl von Mitgliedern der Grundgesamtheit. Die Mitglieder der Stichproben sollten in der Regel so ausgewählt sein, dass sie ein unverzerrtes Abbild der Grundgesamtheit darstellen (siehe Repräsentativität[2]).

Verweise:

[1] Siehe Kapitel 2.1

[2] Siehe Kapitel 2.1.4

2.1.2 Teil- oder Vollerhebung?

Teil- oder Vollerhebung?

Je nach Größe der Grundpopulation, der Zahl der BefragerInnen und der finanziellen Ressourcen eines Forschungsprojekts kann eine Stichprobe unterschiedlich groß gewählt werden. Quantitativ sinnvolle Stichprobengrößen beginnen bei einer Befragtenanzahl von 100 und sind auch dann noch von großen Fehlermöglichkeiten gekennzeichnet. Sinnvoller wären auch hier deutlich höhere Stichprobengrößen. Wenn z.B. ein Meinungsforschungsinstitut die Wahlpräferenzen erhebt, befragt es in der Regel 300- 1000 Personen.

Falls die Grundpopulation relativ klein ist, wie z.B. ausländische HändlerInnen am Brunnenmarkt, lässt sich auch eine Vollerhebung durchführen. Dabei werden alle in Frage kommenden Personen befragt.

2.1.3 Die Ziehung (Auswahl) der Stichprobe

Unter Ziehung der Stichprobe versteht man die Selektion der Elemente der Stichprobe.

Die Formen der Ziehung der Stichprobe lassen sich prinzipiell unterteilen in

- Geschichtete Stichprobenauswahl

- Willkürliches Auswahlverfahren

- Zufallsstichproben

- Klumpenstichproben

2.1.3.1 Geschichtete Stichprobenauswahl (Quotenstichprobe)

Unter einer geschichteten Stichprobenauswahl versteht man ein Auswahlverfahren, bei dem wesentliche Verteilungscharakteristiken[1] der Grundgesamtheit[2] nachgebildet werden.

Einzelne für die Untersuchung als relevant erachtete Merkmale der Zielgruppe werden annähernd im gleichen Verhältnis auf die Stichprobe übertragen, wie sie in der Grundgesamtheit vorkommen.

Relevant sind besonders die Merkmale, welche bei der spezifischen Fragestellung zu besonderer Differenzierung führen können. Bei den Wahlpräferenzen sind das z.B. das Bundesland (Wien ist z.B. traditionell ein ’rotes’ Bundesland, NÖ ein ’schwarzes’); Geschlecht (Frauen haben oft ein ganz anderes Wahlverhalten als Männer); Alter (die Älteren haben eine stärkere Tendenz zur SPÖ, die Jüngeren zu den Grünen) etc.

Beispiel:

Man versucht die aktuellen Wahlpräferenzen der Österreicher mit insgesamt 500 Befragten zu erheben. Da etwa 1/5 der ÖsterreicherInnen in Wien lebt, sollte dementsprechend auch 1/5 der Befragten der Stichprobe, also ca. 100 Personen, aus Wien kommen, aber wesentlich weniger aus dem Burgenland. In gleicher Weise sollte auch die altersmäßige Verteilung der ÖsterreicherInnen wiedergegeben werden, also etwa 1/4 der Befragten über 60 Jahre etc.

Je nachdem, ob die wesentliichen Verteilungsparameter berücksichtigt werden oder einzelne teilweise bewusst verzerrt werden, spricht man von proportional geschichteten Stichproben oder von disproportional geschichteten Stichproben.

Verweise:

[1] Siehe Kapitel 3.1.3

[2] Siehe Kapitel 2.1

2.1.3.1.1 Proportional geschichtete Stichproben

Bei der proportional geschichteten Stichprobe werden die Schichten entsprechend ihrer Verteilung in der Grundgesamtheit ausgewählt. Es wird ein durchgehend treues und unverzerrtes Abbild der Grundgesamtheit angestrebt.

Besonders häufig werden für die Schichtung Geschlecht, Alter und Wohnart verwendet.

2.1.3.1.2 Disproportional geschichtete Stichproben

Unter einer disproportional geschichteten Stichprobe versteht man die bewusste Verzerrung einzelner Verteilungsparameter, um signifikante Aussagen über Randbereiche erhalten zu können. Dabei wird eine Bevölkerungsgruppe überproportional wiedergegeben, um genügend Interviews für sie zu erhalten.

Diese Methode wird v.a. angewandt, um bei beschränkten Stichprobengrößen signifikante[1] Aussagen über kleinere Bevölkerungsgruppen erhalten zu können, die für die Fragestellung besonders interessant sind.

Beispiel: Umfrage zu Reformen im Bildungsbereich

Problemstellung: Man möchte herausfinden, wie die österreichische Bevölkerung eine große Bildungsreform einschließlich des Hochschulwesens einschätzt. Man kann dabei insgesamt 1000 Personen befragen. Befragt man die österreichische Bevölkerung proportional geschichtet, würde man etwa 27 Studierende zu diesem Thema befragen, da mit etwa 220.000 Studierenden an öffentlichen Hochschulen ihr Anteil an der Bevölkerung bei ca. 2,7 % liegt. Man könnte somit bei bloß 27 befragten Studierenden keine verlässliche Aussage über sie bekommen, da ihre spezifische Anzahl zu klein ist. Da sie als Betroffene jedoch für die Fragestellung von besonderer Relevanz sind, könnte man sie übergewichten und 100 oder mehr von ihnen befragen.

Vorteil Kenntnis von Randbereichen, Nachteil Verzerrung des Meinungsbildes

Der Vorteil liegt in einer besseren Kenntnis des Meinungsbilds dieser thematisch wichtigen Subgruppe, der Nachteil dieser Methode in einem Verlust an Repräsentativität. Die Stichprobe ist verzerrt. Wollte man nun allgemeine Aussagen über das Meinungsbild bezüglich dieser Bildungsreform in der österreichischen Öffentlichkeit treffen, müsste man das Meinungsbild der Studierenden auf ihren tatsächlichen Anteil in der Bevölkerung hinuntergewichten.

Verweise:

[1] Siehe Kapitel 1.3.2

2.1.3.1.3 Laufende Kontrolle der Schichtung

Während der Befragungsphase laufende Kontrolle der Schichtung erforderlich

Bei einem quantitativen Forschungsprojekt führt man laufend Erhebungen, meist mit Fragebögen, durch. Dabei muss man stets einen Überblick über die Verteilung[1] der bereits Interviewten haben, um Abweichungen von der Verteilung in der Grundpopulation[2] korrigieren zu können. Wie? Indem man die nächsten Interviewten aus Personengruppen wählt, die bisher unterrepräsentiert waren, deren bisheriger Anteil in der Stichprobe also deutlich geringer als ihr Anteil in der Grundpopulation ist.

Berechnung

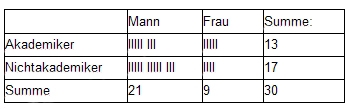

Bei ganz kleinen Umfragen kann man die Aufteilungsverhältnisse mit einer Matrix kontrollieren, in die man laufend mit ‚Stricherln’ einträgt, wen man interviewt hat. Nehmen wir an, in der Grundpopulation hätten wir eine Verteilung von 55 % Männern und 45 % Frauen bzw. von 25 % AkademikerInnen und 75 % NichtakademikerInnen. Mit den Schichtungsfragen stellen wir fest, ob die Verteilung der Interviewten mit der der Grundpopulation übereinstimmt. Daher müssen Schichtungsfragen auch fester Bestandteil der Fragebögen sein. Bisher haben wir folgende Interviews geführt:

In unserer Stichprobe findet sich bisher ein Männeranteil von 70 % (gegenüber 55 % in der Grundpopulation) sowie ein AkademikerInnen-Anteil von 43 % (gegenüber 25 % in der Grundpopulation). Daher müssen wir in Zukunft mehr Frauen und mehr NichtakademikerInnen befragen, solange, bis dieses Ungleichgewicht behoben ist. Zusätzlich gilt es zu bedenken, dass in unserer Stichprobe der Akademikeranteil bei den Männern bisher bei ca. 38 % liegt, der Akademikerinnen-Anteil bei den Frauen jedoch bei ca. 55 %. Sofern beide in der Grundpopulation den gleichen AkademikerInnen-Anteil aufweisen, müssten wir bei den folgenden Interviews darauf achten, dass bei Frauen noch stärker als bei den Männern besonders NichtakademikerInnen interviewt werden.

Verweise:

[1] Siehe Kapitel 3.1.3

[2] Siehe Kapitel 2.1

2.1.3.2 Zufallsstichproben

Unter Zufallsstichproben versteht man Auswahlverfahren einer Stichprobe, bei welchen bei einem theoretisch vorliegenden Register aller Elemente der Grundgesamtheit[1] die Elemente der Stichprobe zufällig gezogen werden.

Man vergleiche dies mit einer Lottoziehung. Man hat ein Register von 45 Lotto-Zahlen, welche die gleiche Ziehungwahrscheinlichkeit aufweisen. Aus diesen werden beim Lotto insgesamt sechs Zahlen gezogen.

Man unterscheidet zwischen einfachen und systematischen Zufallsstichproben. Eine Sonderform der Zufallsstichproben sind die geschichteten Zuallsstichproben.

Allgemeines Problem von Zufallsstichproben:

Es ist äußerst schwierig, Register aufzutreiben oder zu erstellen, welche tatsächlich jedem Element der Grundgesamtheit die gleiche Chance des Gezogenwerdens erlauben. Im Telefonregister scheinen viele Nummern nicht auf, da sie als Geheimnummern unterdrückt werden. Geheimnummern werden wiederum häufiger von besser etablierten Personen verwendet, weshalb sie über das Telefonregister eine geringere Chance haben, erreicht zu werden.

Verweise:

[1] Siehe Kapitel 2.1

2.1.3.2.1 Einfache Zufallsstichprobe

Bei der einfachen Zufallsstichprobe gibt es keinerlei Systematik der Ziehung.

Will man z.B. die Wiener Bevölkerung zum Thema Stadtautobahn befragen, könnte man alle Telefonnummern in einen PC einspeisen (das Register) und sich von einem Programm mit Zufallsgenerator 100 dieser Telefonnummern ’auswerfen’ lassen.

2.1.3.2.2 Systematische Zufallsstichprobe

Bei der systematischen Zufallsstichprobe erfolgt die Ziehung mit System, mit einem bestimmten Ziehungsschlüssel, und damit nicht mehr ganz zufällig.

Beispiel:

Man möchte die Einstellung der Wiener Bevölkerung zur Fristenlösung befragen. Man nimmt das Telefonbuch der Stadt Wien und wählt jede 100. Telefonnummer an.

Potentielle Probleme der systematischen Zufallsstichproben:

Ein Problem dieses Verfahrens kann in einer nicht erkannten Systematik der Verteilung liegen. Wenn man alle Personen befragt, welche jeweils die Türnummer 1 in den Häusern aufweisen, dann wäre die Wahrscheinlichkeit groß, dass Hausmeister deutlich überrrepräsentiert sind.

Systematik darf nicht zu starr sein:

Daher sollte die Systematik nicht zu starr sein. Man könnte z.B. bei der ersten Befragung im 1. Haus das Alter der Person abfragen und aus dem Alter die Türnummer des nächsten abzufragenden Hauses ermitteln, z.B. aus der Ziffernsumme. Nehmen wir an, ein Alter von 32 wird angegeben, dann ist die Ziffernsumme 3+2 = 5, beim nächsten Haus wird also die BewohnerIn der Türnummer 5 befragt usw.

2.1.3.2.3 Geschichtete Zufallsstichprobe

Eine Sonderform der Zufallsstichprobe ist die geschichtete Zufallsstichprobe. Bei dieser findet zuerst eine Einteilung der Stichprobe in sich nicht überlappende Schichten statt. Aus diesen werden wiederum einfache oder systematische Zufallsstichproben entnommen.

Beispiel: Befragung von WienerInnen

Man entscheidet sich zuerst für eine Berücksichtigung der Größenverhältnisse der einzelnen Bezirke, danach realisiert man mit der festgelegten Anzahl von Personen aus diesen Bezirken einfache oder systematische Zufallsstichproben.

2.1.3.3 Willkürliches Auswahlverfahren

Unter einem willkürlichen Auswahlverfahren versteht man eine unkontrollierte Form der Ziehung, bei welcher die Elemente der Grundgesamtheit eine deutlich unterschiedliche Wahrscheinlichkeit der Selektion aufweisen, weshalb von der Stichprobe nicht mehr auf die Grundgesamtheit geschlossen werden kann.

Beispiel:

Eine LehrerIn fragt in der Schule, welche SchülerInnen sich bereit erklären, bei einem sportlichen Ausdauertraining mit Vor- und Nachtest mitzumachen. Eine kleine Zahl von SchülerInnen meldet sich, die wahrscheinlich um einiges fitter als die anderen sind.

Sinnvoll für Rückschlüsse auf Methoden

Auch eine derartige Auswahl kann sinnvoll sein, wenn man z.B. messen möchte, ob sich die Fitness der ausgewählten TeilnehmerInnen durch das Training verbesserte. In der Medizin verwendet man oft dieses Auswahlverfahren, um die Wirksamkeit von Medikamenten zu testen.

Kein Rückschluss auf die Grundgesamtheit

Ein Rückschluss auf die Grundgesamtheit ist jedoch mit dem willkürlichen Auswahlverfahren nicht erlaubt.

2.1.3.4 Klumpenstichproben

Unter einer Klumpenstichprobe versteht man die Auswahl von Klumpen (Bündel von Erhebungselementen wie Schulklassen oder Unternehmen) nach dem Zufallsverfahren.

Dieses Auswahlverfahren erfolgt meist aus Gründen der Ökonomie. Statt einzelne SchülerInnen aus Schulen in 1000 Orten zu befragen, befragt man z.B. alle SchülerInnen aus 30 ausgewählten Orten, von denen man annimmt, dass diese bezüglich ihrer Eigenheiten die Grundgesamtheit der Orte abbilden.

2.1.4 Repräsentativität

Unter Repräsentativität versteht man die angestrebte Eigenschaft von statistischen Erhebungen, die Grundgesamtheit in der ausgewählten Stichprobe möglichst unverzerrt nachzubilden. Eine statistische Erhebung ist repräsentativ, wenn sie auf einer Zufallsstichprobe basiert und Aussagen über die Grundgesamtheit[1] zulässt.

Damit von der Stichprobe auf die Grundgesamtheit geschlossen werden kann, müssen bei den verschiedenen Formen der Ziehungen folgende Bedingungen erfüllt sein:

- Die Grundgesamtheit muss exakt definiert sein. Es muss somit klar festgelegt werden, welche Elemente zur Stichprobe gehören. Gehören z.B. bei einer Untersuchung über AfrikanerInnen in Österreich auch hier geborene Kinder von ZuwanderInnen zur Grundgesamtheit oder ausschließlich in Afrika Geborene?

- Die Grundgesamtheit muss physisch oder symbolisch präsent und manipulierbar sein (sie muss sich durchmischen lassen, jedes Element muss entnehmbar sein). Einfaches Beispiel: Bei einer Lottoziehung wären 45 Kugeln vorhanden, aus denen nach dem Zufallsprinzip jeweils eine gezogen wird.

- Jedes Element darf nur einmal in der Grundgesamtheit vertreten sein. Man darf also nicht z.B. die gleiche Person zweimal mit dem gleichen Fragebogen befragen.

- Die Auswahl muss so erfolgen, dass jedes Element die gleiche berechenbare Auswahlchance (größer 0) hat, in die Stichprobe zu gelangen. Wenn die Befragung ausschließlich an Orten oder zu Zeitpunkten stattfindet, an welchen ein Teil der Grundpopulation nicht oder nur selten erreichbar ist (z.B. ältere Menschen in Discos oder Arbeitende untertags im Park), dann ist die Repräsentativität ebenfalls nicht gewährleistet.

Verweise:

[1] Siehe Kapitel 2.1

2.1.5 Was tun, wenn die Grundpopulation nicht bekannt ist?

Sollte es unmöglich sein, statistische Daten über die Schichtung der Grundpopulation[1] zu erhalten, kann man entweder

- aufgrund vermutlich vergleichbarer Grundpopulationen verallgemeinern. Nehmen wir an, wir kennen den Frauenanteil von SudanesInnen in Wien nicht, Die ZuwanderInnen aus verschiedenen anderen vergleichbaren afrikanischen Ländern (islamisch, arabisch - englisch) weisen einen Frauenanteil von etwa 40 % auf, dann könnte man auch bei Sudanesinnen diesen Wert als Arbeitshypothese ansetzen. Man sollte jedoch unbedingt in der Publikation auf dieses Problem und die daraus folgende Annahme einer bestimmten Schichtung hinweisen.

- ExpertInnen zum Thema befragen, am besten gleich mehrere. Z.B. könnte man das Magistrat befragen, in welchem Ausmaß verschiedene Nationalitäten am Brunnenmarkt vertreten sind; IntegrationsforscherInnen, auch erfahrene Mitglieder der Grundpopulation etc.

Verweise:

[1] Siehe Kapitel 2.1

2.2 Die Operationalisierung

Unter Operationalisierung versteht man die präzise Angabe der Vorgangsweise, mit der ein theoretisches Konstrukt gemessen werden soll (wie z.B. die Akzeptanz von Zuwanderergruppen). Dazu gehört die Auswahl der Indikatoren, die genaue Formulierung der Fragen im Fragebogen, dazu gehören die Antwortkategorien, die Bestimmung der Messinstrumente, die Bestimmung der Genauigkeit der Messung, die Anweisungen an die InterviewerInnen, wie sie die Fragen stellen und welche Zusatzinformationen sie geben dürfen etc. Operationalisierung[1] versucht also bis ins kleinste Detail sicherzustellen, dass die wissenschaftlichen Qualitätserfordernisse[2] für vergleichbare Forschungsarbeiten eingehalten werden können und tatsächlich brauchbare Antworten zu den Themen gefunden werden können, die man zu untersuchen vorgibt.

Was man untersucht bzw. ’misst’, muss in seinen Ausprägungen in sinnvolle und voneinander abgrenzbare Untereinheiten unterteilt werden können.

Untersucht man z.B. die mathematischen Fähigkeiten von Schulkindern, kann man zur Notenskala greifen. Das Geschlecht kann in männlich und weiblich unterteilt werden. Bei der Untersuchung der Körpergröße wird man in Maßeinheiten wie cm oder mm messen. Die Einstellung gegenüber Zuwanderergruppen können wir z.B. in einer fünfteiligen Abstufung wiedergeben, wie z.B. ’sehr positiv’, ’eher positiv’, ’neutral’, ’eher ablehnend’ oder ’absolut ablehnend’. Den Erfolg bei den Bewerbungen von Zuwanderern am Arbeitsmarkt könnte man unterteilen in ’sofort abgelehnt’, ’zu Bewerbungsgespräch eingeladen, aber dann abgelehnt’ und ’aufgenommen’ unterteilen. Den Familienstand kann man in ’ledig’, ’geschieden’, ’verheiratet’, ’verwitwet’ unterteilen.

Verweise:

[1] &&& http://www.univie.ac.at/ksa/elearning/cp/ksamethoden/ksamethoden-43.html

[2] Siehe Kapitel 2.3

2.2.1 Die Suche nach Indikatoren

Im Forschungsentwurf werden verschiedene Hypothesen formuliert. Nun benötigt man eine Reihe von Indikatoren, um die Hypothesen[1] beibehalten bzw. verwerfen zu können.

In vielen Fällen ist die Suche nach den Indikatoren einfach. Möchte man z.B. ermitteln, wie warm zur gleichen Jahreszeit verschiedene Orte sind, dann genügt eine Messung mit dem Thermometer. Meist jedoch sind die Forschungsfragen komplexer und nicht mit einer einzigen konkreten Messungsart zu beantworten.

Beispiel 1:

Nehmen wir an, Sie postulieren, dass die Gesellschaft in Nepal sehr ungleich und damit nicht egalitär ist. Nun bräuchten wir eine Reihe von sehr viel spezifischeren Fragestellungen, eigentlich Subhypothesen, deren Synthese zur Beantwortung der allgemeinen Hypothese führen kann. Wir könnten zwischen materieller, rechtlicher und politischer (Un-)Gleichheit unterscheiden. Wir könnten Vermögensverhältnisse in verschiedenen Schichten betrachten; den Zugang zu staatlichen und privaten Ressourcen; wir könnten die Vertretung verschiedener Gruppen der Gesellschaft (Frauen, Adelige, Bauern etc.) im Parlament und anderen öffentlichen Gremien betrachten. Wir könnten die Schulbesuchsquote kontrastiv untersuchen etc.

In all diesen Punkten müssen wir äußerst konkret und präzise werden. Bezüglich des Schulbesuchs könnte man die Zahl der Jahre in der Schule, den maximalen Ausbildungsgrad etc. abfragen. Bezüglich des Vermögens Grundstücke, Häuser, Kapital, Vieh, andere Besitztümer, Leibeigene etc. Wir könnten Einschätzungen abfragen, ob Heiraten zwischen Adeligen und Nichtadeligen als akzeptabel empfunden werden, ob die Befragten annehmen, dass Arme und Reiche vor Gericht die gleichen Chancen haben usw.

Beispiel 2:

Sie nehmen an, dass viele Menschen in Wien AraberInnen ablehnen und oft sogar rassistisch gegenüberstehen. Sie könnten nun in einem Fragebogen an die Wiener Bevölkerung die Wertschätzung des Islams, der arabischen Kultur abfragen. Sie könnten fragen, in welchem Maße man annimmt, dass AraberInnen besonders leicht zu Terrorismus neigen. Sie könnten fragen, ob man sich vorstellen könnte, AraberInnen als angeheiratete Familienmitglieder zu akzeptieren. Sie könnten die Bereitschaft abfragen, AraberInnen Wohnungen zu vermieten. Sie könnten die Befragten ersuchen, die ersten Assoziationen zu nennen, die ihnen beim Begriff AraberInnen einfallen. Sie könnten die Befragten ersuchen, Ihnen das dominante Gefühl zu nennen, welches sie in Gegenwart von AraberInnen spüren usw.

Letztendlich könnte man sich auf einen Schlüssel einigen, mit welchem Anteil die mit den verschiedenen Detailfragen erhaltenen Informationen in einen Sammelparameter (Beispiel 1: Ungleichheit/Gleichheit; Beispiel 2: Rassismus gegenüber AraberInnen) einfließen.

Verweise:

[1] &&& http://www.univie.ac.at/ksa/elearning/cp/ksamethoden/ksamethoden-49.html

2.2.2 Das Messen

Unter Messung versteht man die quantitative Bestimmung von Sachverhalten in Form einer Messgröße. d.h. wir ordnen diesen Zahlen zu.

Misst man die Temperatur eines Körpers, wird man in unseren Regionen in der Messgröße Celsius messen, in anderen in Fahrenheit etc. Messen wir die Körpergröße, dann messen wir bei größeren Körpern in Metern und Zentimetern, bei Kleinstlebewesen aber auch in Millionstel Metern und darunter. Messen wir das Haushaltseinkommen, werden wir in Euro messen. Bei der Messung von Einstellungen und sozialen Sachverhalten kann man selbst die Messgrößen bestimmen. So könnte man bei der Einschätzung der Sympathie für eine bestimmte Kultur fünf verschiedene Messgrößen festlegen, wie z.B. ’sehr sympathisch’, ’sympathisch’, ’neutral’, ’weniger sympathisch’ und ’unsympathisch’.

Die Antwortkategorien müssen fair und ausgewogen sein

Es wäre tendenziös und unseriös, in der obigen Sympathie-Skala im positiven Bereich nur ’sehr sympathisch’ anzugeben, im negativen jedoch die zwei vorhandenen Unterscheidungen. Dies könnte dazu führen, dass Antwortende, die nur eine leichte Sympathie für die andere Kultur empfinden, zum neutralen Wert ausweichen. Daher gilt als Grundregel, dass die Zahl der möglichen Antwortvarianten bei derartigen Fragen im negativen Bereich genauso hoch wie im positiven Bereich sein soll.

Messungen beinhalten immer das Problem von Messfehlern.

2.2.2.1 Messfehler

Unter Messfehler versteht man die Abweichung des Ergebnisses von Messungen von den realen Gegebenheiten. Wo eine Messung erfolgt, sollte man immer die Möglichkeit von Messfehlern berücksichtigen. Man kann zwischen zufälligen, systematischen und fahrlässigen Messfehlern unterscheiden.

A. Zufällige Messfehler:

Zufällige Messfehler sind von den Messenden nicht zu kontrollieren. Wenn man zum Beispiel eine bestimmte Personengruppe zu einem sensiblen Thema befragen möchte und gerade am Tag vorher ein (den InterviewerInnen unbekanntes) Ereignis eintritt, welches ihre Neigung zu ehrlichen Antworten temporär verändert, während bei Vergleichsgruppen im gleichen Zeitraum nichts Vergleichbares auftritt, können verfälschte Ergebnisse auftreten. Misst man die Regenfälle in der Sahelgegend, kann es sein, dass ein Ort deutlich besser und gleichmäßiger beregnet wird, als die nicht gemessenen Nachbarorte, im nächsten Jahr kann es umgekehrt sein. Es gibt jedoch einen sogenannten Zentralen Grenzwertsatz der Statistik (Wikibooks)[1], nach welchem zufällige Fehler sich im Laufe der Zeit ausgleichen und einer Normalverteilung zustreben. Man kann daher postulieren, dass die zufälligen Messfehler bei häufigen Messungen zum Ausgleich tendieren.

B. Systematische Messfehler:

Systematische Messfehler können durch fehlerhafte Messgeräte entstehen, wie z.B. die Gewichtsmessung durch eine verstellte Waage; die Zeitmessung durch eine ungenaue Uhr; aber auch z.B. eine Kommunikationsform, welche den Zugang zu manchen Informationen kaum erlaubt. So ist es möglich, dass besonders hoch emotionale Angelegenheiten in einer Fremdsprache zu anderen Antworten als in seiner Muttersprache führen. Man überlege sich, ob es einem in einer Fremdsprache ähnlich schwer wie in seiner Muttersprache fällt, z.B. Ich liebe Dich zu sagen, wo beim Aussprechen ähnlicher Sätze auch Assoziationen mit Enttäuschungen u.a. verbunden sein können und damit auch die Angst vor Zurückweisung.

Ein Teil der systematischen Messfehler kann durch stetige Kontrolle und kritische Hinterfragung der Messinstrumente behoben werden.

C. Fahrlässige Messfehler:

Grobe Messfehler beruhen auf menschlichen Fehlern. Man trägt z.B. beim Alter 15 statt 51 ein, schreibt eine Antwort in die falsche Spalte; vergisst eine Frage zu stellen oder zu beantworten. Man vermittelt beim Interview eigene Einstellungen, welche mit großer Wahrscheinlichkeit zu einer veränderten Reaktion des Befragten führen (wenn man z.B. einem Befragten deutlich zeigt, dass man seine Einstellungen und Meinungen geringschätzt).

Weiterführendes zu Messfehlern:

Messfehler (Wikipedia)[2]

Verweise:

[1] https://de.wikibooks.org/wiki/Statistik:_Zentraler_Grenzwertsatz

[2] http://de.wikipedia.org/wiki/Messfehler

2.2.3 Vom Fragebogen zum Codeplan

Unter einem Codeplan verstehen wir die Auflistung aller verwendeten Variablen mit einer eindeutigen Information zur inhaltlichen Bedeutung der numerischen Codes, eventuell noch von weiteren Informationen begleitet, welche sich auf den Messvorgang beziehen.

In einem Codeplan halten wir eindeutig fest, welchen Variablennamen Fragen des Fragebogens entsprechen, wie verschiedene Ausprägungen von Variablen gemessen werden (z.B. in cm für die Körpergröße oder in Ja/Nein für bestimmte Erfahrungen) und wie diese Ausprägungen in eine numerische Form übersetzt werden, was überhaupt erst eine maschinelle quantitative Analyse erlaubt.

Statistikprogramme benötigen automatisch interpretierbare Datentypen

Statistikprogramme benötigen für Berechnungen bestimmte Datentypen, die in der Regel numerisch sind. Kein Statistikprogramm kann in den Antwortkategorien ’sehr’, ’eher schon’, ’durchschnittlich’, ’eher weniger’, ’überhaupt nicht’ eine logische Reihe erkennen, dass also diese Bezeichnungen für verschiedene logische Abstufungen stehen, nämlich für eine Ordinalskala[1].

Damit ein Statistikprogramm wie SPSS die logische Reihenfolge erkennen und danach Analysen über diese bilden kann, müssen die Textwerte in numerische umcodiert werden. Im Codeplan, d.h. der Dokumentation über die ursprünglichen Text- Begriffe und ihrer numerischen Entsprechungen, werden diese Umcodierungen festgehalten. Im obigen Beispiel könnte man ’sehr’ immer durch 1, ’eher schon’ durch 2, ’durchschnittlich’ durch 3, ’eher weniger’ durch 4 und ’überhaupt nicht’ durch 5 ersetzen. Nun ist eine für die Software durchgehende Reihe von 1-5 entstanden, die vom kleinsten zum größten Wert gereiht ist.

Aktuelle Statistikprogramme wie SPSS rechnen intern mit diesen numerischen Daten, können mit einfachen Befehlen jedoch bei der Ausgabe der Ergebnisse automatisch die urspünglichen Textinformationen verwenden.

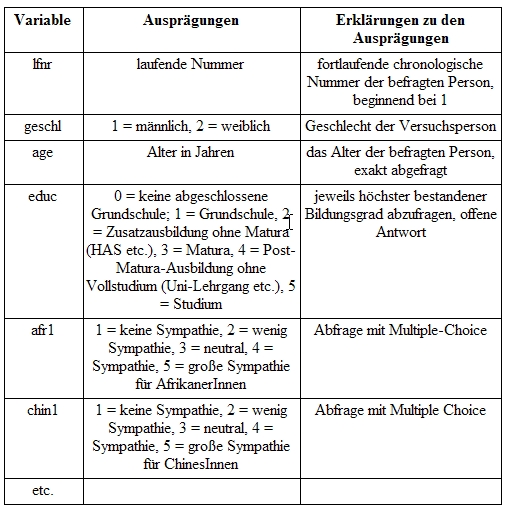

Beispiel eines Codeplans:

Verweise:

[1] Siehe Kapitel 3.1.2.3

2.2.3.1 Dateneingabe und Erstellung einer Datenmatrix

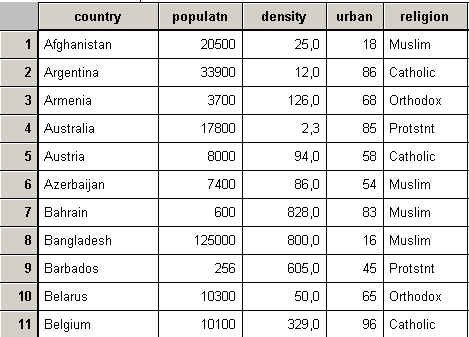

Unter einer Datenmatrix versteht man eine Tabelle, in welcher alle Messungen an den Versuchsobjekten zusammengefasst werden. Die Daten sind normalerweise so angeordnet, dass jede Zeile der Datenmatrix alle Messungen an einem einzelnen Datenobjekt enthält. In den Zeilen stehen somit von links nach rechts die Angaben zu einer Person (bzw. zu den Untersuchungsobjekten), während in den Spalten die Variablen eingetragen werden.

Siehe z.B. die ersten Spalten und Zeilen der SPSS-Datei zur weltweiten Entwicklung world95.sav:

Die Untersuchungsobjekte sind hier eindeutig durch ihre in der ersten Spalte stehenden (Länder-)Namen identifiziert. Von links nach rechts werden danach in den einzelnen Zeilen durch Variable Informationen zu den jeweiligen Ländern angegeben: Bevölkerungsgröße, Bevölkerungsdichte, Prozentsatz der städtischen Bevölkerung, Religion etc.

Es ist äußerst empfehlenswert, die Datenmatrix in der hier beschriebenen Weise zu verwalten, da alle führenden und gängigen Analyse- und Darstellungsprogramme (Excel, SPSS etc.) die gleiche Anordnung verwenden.

2.2.3.2 Umcodierung mit SPSS

SPSS benötigt gleichzeitig für viele Funktionen numerische Daten, wo Daten in String (oder Text-)Format vorliegen. So kann SPSS bei reinen Textdaten, wie z.B. ’Sehr Gut’ oder ’Gut’ nicht erkennen, dass ’Sehr Gut’ eine höhere Intensität bzw. Qualität als ’Gut’ wiederspiegelt. SPSS würde eine sinnvolle Rangfolge jedoch in numerischer Form erkennen.

SPSS erlaubt es, Stringvariable automatisch in numerische zu codieren.

Dazu benützen Sie die Funktion TRANSFORMIEREN - UMCODIEREN in der Menüleiste. Nun können Sie sich entscheiden, ob die Umcodierung in die gleiche oder in eine andere Variable erfolgen soll. Es ist besser, sich für eine andere Variable zu entscheiden, da durch die Umcodierung (man kann auch mehrere Werte zu einem einzigen neuen umcodieren) Informationsverlust auftreten kann (ob willentlich oder durch einen Bedienungsfehler). Dieses Problem wird durch Umcodierung in eine neue Variable ausgeschlossen.

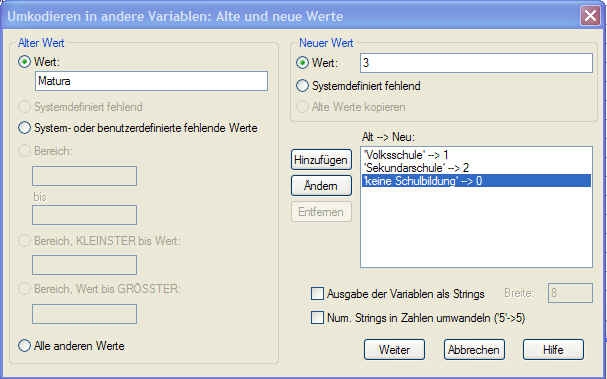

Sie wählen nun die Variable aus, welche umcodiert werden soll und geben im Feld Ausgabevariable einen neuen Namen dafür ein (der aus Gründen verschiedenster Kompatibilität) acht Zeichen nicht überschreiten darf. Im Feld darunter können Sie jedoch einen beliebig langen und expressiveren Namen wählen.

Klicken Sie nun auf Alte und neue Werte. Wenn Sie einzelne Werte umcodieren möchten, geben Sie im Feld Wert denselben ein (z.B. Matura). Nun benötigen Sie einen neuen Wert dafür. Dafür könnten Sie z.B. die Zahl 3 im Feld Neuer Wert eingeben. Im oben angeführten Beispiel wären verschiedene abgeschlossene Ausbildungsstufen in eine logische Reihenfolge gebracht.

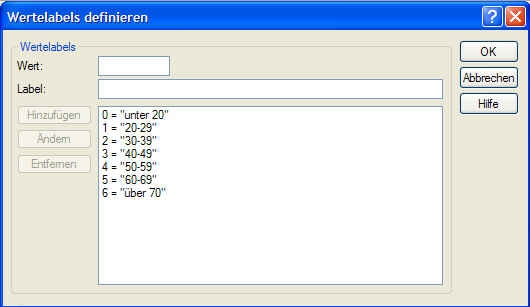

Falls Sie mehrere (numerische) Werte zu einem einzigen neuen zusammenfassen möchten, können Sie einen Bereich angeben (z.B. Bereich 20 bis 29), wenn Sie alle zwischen 20-29jährigen in eine einzige Altersklasse ’zwischen 20 und 30' einbringen möchten). Klicken Sie nach jeder einzelnen Angabe zur Umcodierung auf Hinzufügen.

Klicken Sie am Ende auf Weiter und dann auf OK. Ihre Daten werden nun in die neue Variable umcodiert. Erst jetzt wäre es Ihnen möglich, dass SPSS die Ausbildung nach Jahren und Qualität sinnvoll reihen kann und natürlich auch viele weitere (damit zusammenhängenden) Analysen rechnen kann. So wäre erst jetzt die Berechnung einer Korrelation[1] zwischen dem Ausbildungsgrad und dem Einkommen möglich.

Verweise:

[1] Siehe Kapitel 3.5.3

2.2.3.3 Automatische Rückcodierung mit SPSS

Damit SPSS mit Daten rechnen kann, wurden diese in numerischer Form eingegeben oder in eine neue numerische Variable umcodiert. Wenn Sie nun eine auf diesen neuen Variablen basierende Analyse starten, wirken die Ergebnisse ohne zusätzliche Information wenig informativ.

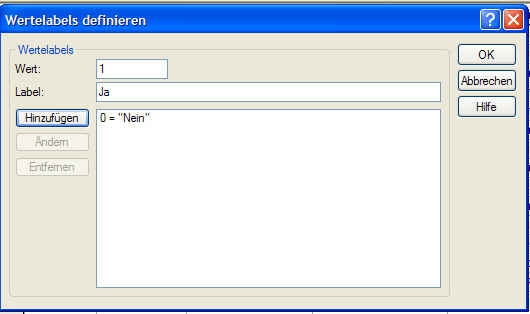

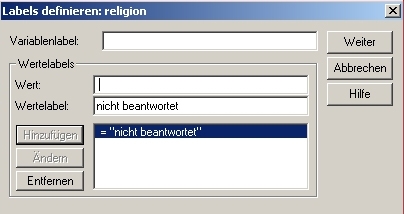

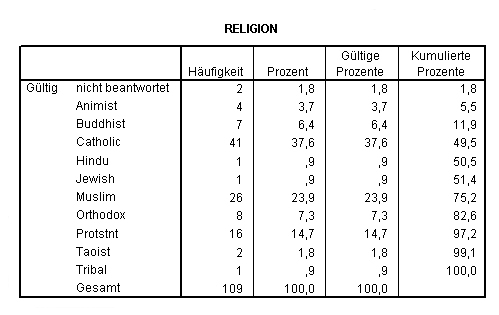

Niemand könnte ohne Zusatzinformation wissen, dass 0 für Nein und 1 für Ja steht. Damit SPSS intern mit den numerischen Daten rechnen kann, wir jedoch bei allen Ausgaben (Diagramme, Analysen etc.) informative Bezeichnungen erhalten, klicken wir in SPSS unten links auf die Variablenansicht. Im neuen Fenster finden wir in der Zeile der neuen Variable den Punkt Variablenlabel. Nach Doppelklick darauf erscheint folgendes Fenster:

Wir geben nun für den Wert das gewünschte Label ein. Wir möchten, dass statt 0 der aussagekräftige Text Nein erscheint, statt 1 der aussagekräftige Wert Ja. Nach Eingabe aller automatisch durchzuführenden Änderungen klicken wir auf OK.

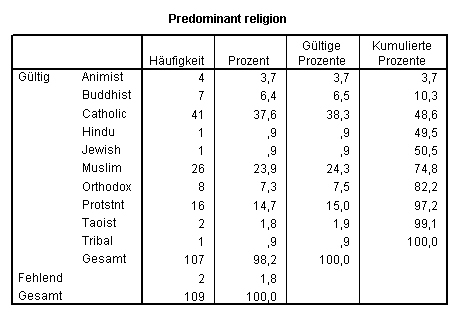

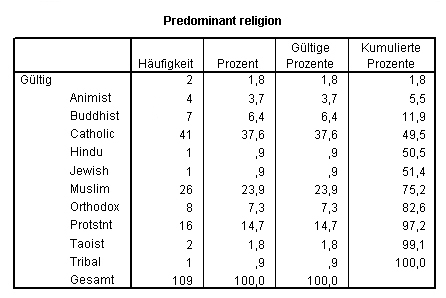

Wenn wir nun die gleiche Häufigkeitsberechnung wie oben durchführen, erhalten wir nun folgende leichter verständliche Tabelle:

2.3 Gütekriterien quantitativer Untersuchungen

Statistische Untersuchungen müssen wie jede andere Form wissenschaftlicher Betätigung den Kernansprüchen[1] der Reliabilität, der Validität und der Objektivität genügen:

Reliabilität:

Unter Reliabilität oder Zuverlässigkeit versteht man die formale Genauigkeit wissenschaftlicher Untersuchungen. Darunter versteht man, dass die Untersuchungen mit einem Höchstmaß an Anstrengungen verbunden werden, Messfehler jeder Art auszuschließen. Reliabilität ist somit ein Indikator für die Replizierbarkeit (Wiederholbarkeit) der Ergebnisse. Fragen müssen z.B. so eindeutig formuliert sein, dass sie nicht höchst unterschiedlich verstanden werden können.

Validität:

Validität liegt vor, wenn wenn die gewählten Indikatoren, Fragen und Antwortmöglichkieten wirklich und präzise das messen, was gemessen werden soll.

Wenn man die Frage stellt, ob der Proband Schweinefleisch isst, so ist die Verneinung noch keineswegs ein Beweis dafür, dass er Vegetarier ist, sondern nur, dass er eben Schweinefleisch aus verschiedenen Gründen nicht mag. Wäre die Frage nach dem Essen von Schweinefleisch die einzige auf Fleisch bezogene Frage im Fragebogen, so wäre der Fragebogen nicht valide, um auf Vegetarismus zu schließen.

Objektivität:

Die Objektivität von Messverfahren und Fragen ist weitgehend gewährleistet, wenn die Wahl der Messenden, InterviewerInnen, PrüferInnen keinen Einfluss auf die Ergebnisse hat.

Objektivität wäre z.B. zweifelhaft, wenn man verunsicherte Männer mit einem persönlich überreichten Fragebogen zu ihrem Sexualleben einmal von ebenfalls verunsicherten Männern und das andere Mal von jungen, attraktiven und selbstbewussten Frauen befragen lassen würde, wobei die Fragen von den InterviewerInnen persönlich gestellt und auch die Antworten von ihnen niedergeschrieben werden. Man würde mit hoher Wahrscheinlichkeit äußerst unterschiedliche Antworten erhalten. Genauso müßte man mit Verfälschungen rechnen, wenn Firmenchefs oder -chefinnen ihre Angestellten zur Zufriedenheit mit ihrer Arbeitssituation befragen.

Gütekriterien und andere Fehlerquellen erfordern, dass statistische Untersuchungen stets mit äußerster Sorgfalt durchgeführt werden: von der Erhebung der Daten bis zu deren Analyse, dass also die richtigen Methoden angewandt werden, deren Wahl auf der Eigenart der Daten und ihrer Verteilungen beruht und dass die Interpretation keineswegs über die Aussagekraft der Daten hinausgeht.

Verweise:

[1] &&& http://www.univie.ac.at/ksa/elearning/cp/ksamethoden/ksamethoden-76.html

2.4 Fehlerquellen bei statistischer Arbeit

Statistik ist der Versuch, aus einem Ausschnitt der Realität auf die Gesamtheit zu schließen. Dies bedeutet, dass unsere Aussagen über die (gesamte) Realität immer, ohne Ausnahme, mit einem Irrtumsrisiko behaftet sind, da wir nicht über vollständige Daten zur Grundgesamtheit[1] verfügen. Statistisch sprechen wir dabei von Fehlern der ersten und der zweiten Art.

Während Fehler der ersten und der zweiten Art zu nicht eliminarbaren Risiken der statistischen Arbeit gehören und auch bei sorgfältiger Herangehensweise nicht ausgeschlossen, sondern nur berücksichtigt werden können (siehe Irrtumswahrscheinlichkeit[2]), hängen individuell bedingte Fehler mit Mängeln bei der Datenaufnahme, -übertragung oder Analyse zusammen. Wir könnten diese unter fehler- bzw. mangelhafte Daten zusammenfassen.

Verweise:

[1] Siehe Kapitel 2.1

[2] Siehe Kapitel 1.3.2

2.4.1 Fehler erster und zweiter Art

Unter Fehler der ersten bzw. zweiten Art verstehen wir das systembedingte Problem, dass Hypothesen auch bei sorgfältigem Vorgehen fälschlich bestätigt oder verworfen werden.

Hypothesen am Beginn der Untersuchung

Bei Forschungsprojekten formulieren wir Hypothesen, deren Richtigkeit wir mit geeigneten Forschungs- und Analysemethoden untersuchen wollen. Eine derartige Ausgangshypothese oder Nullhypothese (in Kurzform oft auch H0 bezeichnet) könnte lauten: ’AfrikanerInnen werden am Arbeitsplatz weniger geschätzt als ChinesInnen.’.

Das Vorliegen einer Hypothese bedingt auch, dass es als Kontrast eine alternative Hypothese gibt (die wir bei der Erstellung des Konzepts als meist weniger wahrscheinlich einschätzen), die Alternativhypothese (in Kurzform oft auch H1 genannt). In unserem Fall könnte diese lauten: ’AfrikanerInnen werden am Arbeitsmarkt nicht weniger geschätzt als ChinesInnen.’.

Annahme oder Verwerfung von Hypothesen ist immer an Wahrscheinlichkeiten gebunden

Bei statistischen Analysen versuchen wir, Ergebnisse auf hohem Signifikanzniveau[1] zu erreichen. Wir sprechen davon, dass die gefundene Aussage mit einer Irrtumswahrscheinlichkeit von weniger als 5 %, weniger als 1 %, weniger als 1 ‰ zutrifft. Das bedeutet, dass unser Ergebnis, auf das wir so stolz sind, dennoch in 5 % aller Fälle, in 1 % aller Fälle etc. rein zufällig entstehen kann und, bei einer genügend häufigen Wiederholung, sogar muss.

Andererseits ist genauso denkbar, dass unser Ergebnis rein zufällig nicht den starken Zusammenhang zeigt, der normalerweise erscheint. Wir könnten auch bei großer Sorgfalt bei der Auswahl der Stichprobe überdurchschnittlich häufig auf Personen treffen, welche AfrikanerInnen besonders positiv gegenüber stehen.

Fehlerhafte Verwerfung bzw. Annahme von Hypothesen möglich

Es können also zwei verschiedene Fehler auftreten:

A. die Nullhypothese wird verworfen, obwohl sie richtig ist. Dies nennt man auch Fehler der ersten Art oder Alpha-Fehler;

B. die Nullhypothese wird angenommen, obwohl sie falsch ist. Dies bezeichnet man auch als Fehler der zweiten Art oder Beta-Fehler.

Mit der Zahl der statistischen Berechnungen steigt die Wahrscheinlichkeit von Fehlern der 1. oder 2. Art

Das Risiko, einem der beiden Fehler aufzusitzen, steigt natürlich mit der Höhe der Irrtumswahrscheinlichkeit sowie mit der Zahl der durchgeführten Analysen. Moderne PCs und Statistik-Software laden geradezu dazu ein, in kurzer Zeit tausende von Hypothesen zu überprüfen. Wenn wir 100 Variable miteinander kreuzen, erhalten wir (100x99)/2 Vergleiche, d.s. 4950 einzelne Untersuchungen auf signifikante Zusammenhänge. Wenn wir diese mit Chi-Quadrat-Tests auf dem 5 %-Irrtumsniveau untersuchen, erhalten wir im Normalfall 247,5 falsche Zusammenhänge (4950*0,05). Wir würden also in 247 Fällen einen Zusammenhang annehmen, obwohl er nicht vorhanden ist (Alpha-Fehler).

Kontrolle durch qualitative Überlegungen erforderlich

Derartige Massenvergleiche zeigen auch deutlich, dass statistische Berechnungen nicht losgelöst von qualitativen Überlegungen stattfinden dürfen. Bei statistischen Untersuchungen überraschend aufgetauchte Zusammenhänge müssen auch eine gewisse Stabilität und Systemkohärenz aufweisen, um akzeptiert werden zu können. D.h. sie müssen in einem gewissen Rahmen reproduzierbar sein und sie sollten nicht im Widerspruch zu offensichtlichen Fakten sein.

Verweise:

[1] Siehe Kapitel 1.3.2

2.4.2 Fehlerhafte oder mangelnde Daten

Fehler und Mängel können bei einer Reihe von Vorgängen bei statistisch unterstützten Forschungsprojekten erfolgen bzw. auftreten, wie z.B.:

A. Operationalisierungsfehler: bei der Operationalisierung[1] wurden verzerrende Messmethoden festgelegt;

B. Codierfehler: bei der Codierung[2] wurden, z.B. bei der Übertragung von Text-Daten in numerische Daten für interne Berechnungen von SPSS, Fehler begangen (z.B. die Vergabe des Zahlenwerts 4 in der Notenskala für ’Befriedigend’);

C. Interviewerfehler: bei der Datenaufnahme wurden fehlerhafte Werte eingetragen (z.B. eine Kinderzahl von 71 statt 7);

D. Widersprüchliche Datenlage: die Versuchspersonen oder die Datenquellen lieferten widersprüchliche Informationen, die sich in den Datenblättern wiederfinden;

E. Antwortverweigerung: verschiedene Fragen wurden von Versuchspersonen nicht beantwortet oder waren durch die Datenlage nicht erhebbar;

F. Eingabefehler: Datensätze wurden doppelt eingegeben;

G. Analysefehler: für die Analyse der Daten wurden die falschen Methoden[3] verwendet;

H. Interpretationsfehler: die Ergebnisse wurden richtig gerechnet, aber falsch interpretiert;

I. Grafiken[4] und Tabellen werden falsch oder ungenügend mit Zusatzinformationen versehen, was sowohl zu mangelndem Verständnis wie auch zu Nichtüberprüfbarkeit der Ergebnisse führen kann.

Verweise:

[1] Siehe Kapitel 2.2.1

[2] Siehe Kapitel 2.2.3.2

[3] Siehe Kapitel 3.1

[4] Siehe Kapitel 3.6.3

2.4.2.1 Eingabefehler

Meist werden Umfrageergebnisse zuerst handschriftlich aufgezeichnet. Danach werden die Daten in den PC übertragen, was mehrere potentielle Fehlerquellen berührt. Eine wenig leserliche Schrift kann zu Irrtümern bei der Eintragung in die Datenmatrix führen, genauso ’hängengebliebene Finger’ auf einer kleinen Tastatur, aber natürlich auch bewusste Falschangaben.

SPSS und Excel bieten verschiedene Möglichkeiten, die Eingabe von falschen Daten zu erschweren:

A. durch die Wahl geeigneter Datentypen

B. durch die Überprüfung, ob sich der eingetragene Wert innerhalb vorgegebener Grenzen befindet = Gültigkeitsprüfung.

2.4.2.1.1 Wahl geeigneter Datentypen mit SPSS

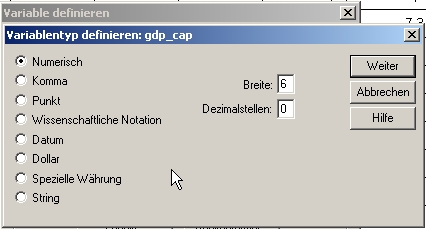

Verringerung des Risikos durch Wahl geeigneter Datentypen

Besonders wichtig ist die richtige Definition des Datentyps (-> VARIABLENANSICHT - DATENTYP). In einem Stringfeld (oder Textfeld) können beliebige Zeichen stehen, in einem numerischen Feld nur Zahlen. Das bedeutet, dass durch Verschreiben keinerlei Buchstaben in ein numerisches Feld ’rutschen’ können. Der Datentyp kann jedoch noch wesentlich enger gefasst werden. Wenn ich im Feld Breite die Zahl 4 eintrage, kann ich z.B. bei numerischen Daten ausschließen, dass Jahreszahlen fehlerhaft durch Vertippen mit fünf Ziffern eingegeben werden. Gibt man bei Dezimalstellen 0 ein, sind nur ganze Zahlen möglich.

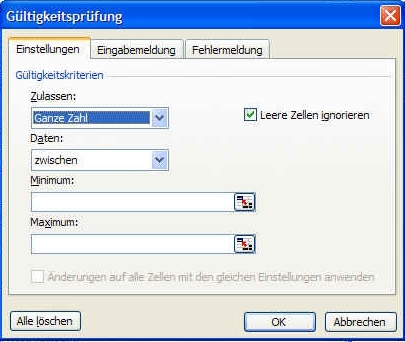

2.4.2.1.2 Gültigkeitsprüfung der Daten mit Excel

Unter Gültigkeitsprüfung von Daten versteht man die automatische Prüfung, ob aufgenommene Ausprägungen sich innerhalb eines vorgegebenen Bereichs befinden. Jeder außerhalb dieses Bereichs liegende Wert wird bei der Eingabe mit einer Fehlermeldung abgewiesen.

Für die meisten Variablen lassen sich mit geringer Sachkenntnis Ober- und Untergrenzen definieren, welche alle real auftretenden Ausprägungen umschließen. So könnte man bei der Aufnahme der Körpergröße von Erwachsenen eine Untergrenze von 80 cm und eine Obergrenze von 3 m annehmen; beim Lebensalter bei Erwachsenen eine Untergrenze von 18 und eine Obergrenze von 130; bei Schulnoten eine Untergrenze von 1 und eine Obergrenze von 5; beim Einkommen von Studierenden eine Untergrenze von 0 und eine Obergrenze von 4000 Euro.

Mit Excel geschieht dies folgendermaßen:

A. Man markiert die Spalte der Ausprägungen

B. In der Menüleiste auf Daten und danach auf Gültigkeit klicken

C. Nun unter Zulassen Angabe des Datentyps machen. Wenn z.B. die Zahl der Kinder eingetragen werden sollte, würden wir hier Ganze Zahl wählen. Wählt man Liste aus, gelten alle Werte als gültig, welche sich in einer spezifischen Datei befinden (der Liste).

D. Unter Daten gibt man die Richtung der Ausprägungen an, also z.B. größer als, zwischen, ungleich etc. In unserem Fall der Kinderzahl wählen wir zwischen (auch größer oder gleich wäre denkbar).

E. Nun geben wir als Minimum-Wert ' die untere Begrenzung ein, in unserem Falle 0, da weniger Kinder nicht möglich sind und als Maximum in unserem Falle die Zahl 20 (kaum denkbar, dass jemand in Industrieländern eine höhere Kinderzahl aufweist).

F. Unter Eingabemeldung könnte man eine Meldung ausgeben lassen, welche bei Einträgen im Feld automatisch auf die Grenzen hinweist

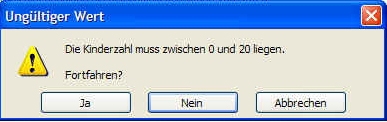

G. Wichtiger ist es, unter Fehlermeldung anzugeben, warum ein eingetragener Wert als ungültig abgelehnt wird. Dazu wählen wir unter Typ eine bestimmte Signalform, in unserem Falle Warnung; danach geben wir unter Titel eine aussagekräftige Kurzmeldung und unter Fehlermeldung ausführlichere Erklärungen dazu ein.

Falls wir nun in Excel in der betreffenden Spalte für Kinderzahlen die Ausprägung 22 eingeben, erhalten wir folgende Warnmeldung:

2.4.2.2 Doppelte Datensätze

Mitunter kann es geschehen, dass der gleiche Datensatz fehlerhafterweise doppelt eingegeben wird.

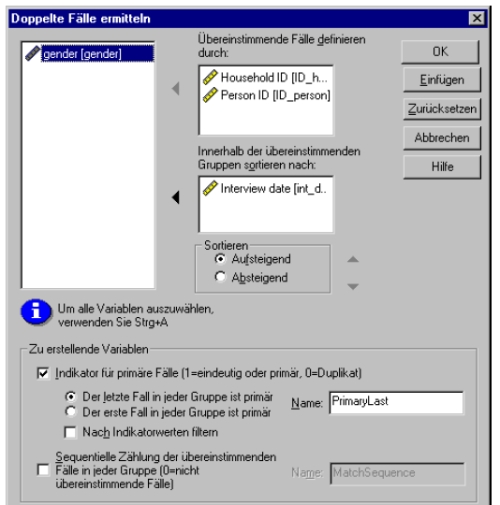

Doppelt eingegebene Datensätze kann man in SPSS mit folgender Funktion finden:

Klicken Sie auf DATEN - DOPPELTE FÄLLE ERMITTELN. Sie sehen folgendes Fenster:

Die wesentlichen Einträge hier sind:

A. Geben Sie unter Übereinstimmende Fälle definieren durch die Variablen an, welche zur Identifikation von Doppelgängern dienen. Das können normalerweise nur Variable sein, bei welchen Einträge eindeutig sein sollen (natürlich ist Eindeutigkeit auch durch eine Kombination mehrerer Variable erreichbar).

B. Sie können unter Innerhalb der übereinstimmenden Gruppen sortieren nach: noch eine Variable angeben, nach der sortiert werden soll.

Haben Sie somit doppelte Einträge gefunden, können Sie Fall für Fall entscheiden, wie Sie damit umgehen.

2.4.2.3 Fehlende Einträge

Was tun, wenn Einträge fehlen?

Nur bei den wenigsten Umfragen werden alle Fragen von allen Befragten beantwortet. Besonders tabuisierte Fragen wie vielleicht nach Bereichen der Sexualität, dem Einkommen, den politischen Neigungen werden oft nicht oder nur neutral beantwortet. Es stellt sich daher die Frage, ob und wie man die fehlenden Einträge interpretieren kann. Ein weiser Spruch der Kommunikationsforschung lautet: ’Man kann nicht nicht kommunizieren’ (Paul Watzlawick). Das bedeutet, dass vor allem bei tabusierten Fragen auch die Nichtbeantwortung von Fragen eine Information darstellt. Es könnte dementsprechend sein, dass bei manchen Fragen eine Nichtbeantwortung bedeutet: "Ich möchte nicht, dass man weiß, wie ich über diesen Bereich denke."

Beispiel: geringe Bekenntnisquote von FPÖ- WählerInnen

Viele Jahre lang hatten besonders FPÖ-WählerInnen während der Haider-Jahre große Angst, sich in Umfragen vor Wahlen zu ihrer Partei zu bekennen. Die Wahlergebnisse fielen daher für die FPÖ durch 1,5 Jahrzehnte stets wesentlich besser aus als die Umfrageergebnisse, was u.a. dazu führte, dass ihre Bekennerzahlen in Umfragen von den Meinungsforschungsinstituten einen substantiellen Zuschlag bekamen, um sich der tatsächlichen Unterstützung dieser Partei anzunähern.

Nichtbeantwortung auch durch Fehler möglich

In anderen, neutralen, Bereichen wird eine Nichtbeantwortung wieder eher als Übersehen oder als Ratlosigkeit (die Frage ist vielleicht unverständlich formuliert) gedeutet werden. Es gäbe kaum einen denkbaren Grund, die Frage nach seinem Lieblingsobst nicht zu beantworten.

Je nach Tabuisierungsgrad der Frage sind fehlende Einträge unterschiedlich aussagekräftig

Je nach Sachlage kann daher eine Nichtbeantwortung eine Art von Information oder einen Mangel darstellen. Im ersten Fall könnte es sein, dass z.B. besonders Personen, welche eine extrem abwehrende Haltung gegenüber MigrantInnen aufweisen (wie aus einer anderen Fragestellung erkennbar), besonders zur Nichtbeantwortung der Frage ’Welche Partei würden Sie wählen, wenn morgen Wahltag wäre?". Das heißt, dass wir uns bei auffallend häufiger Nichtbeantwortung von bestimmten Fragen die Frage stellen sollten, ob es bei den Nichtbeantwortenden gewisse Gemeinsamkeiten gibt und damit auch spezifische Motive der Nichtbeantwortung.

Wir müssen also bei der Behandlung der beiden Arten der Nichtbeantwortung differenzieren: im Falle der informationstragenden Nichtbeantwortung sollte der Antwort dennoch ein gewisser Wert beigemessen werden. Im Falle der informationsleeren Nichtbeantwortung sollten wir die Nichtantwort einfach aus der Gesamtzahl der möglichen Antworten ausschließen und dadurch die Stichprobengröße für diese Frage verkleinern.

2.4.2.3.1 Behandlung fehlender Daten mit SPSS

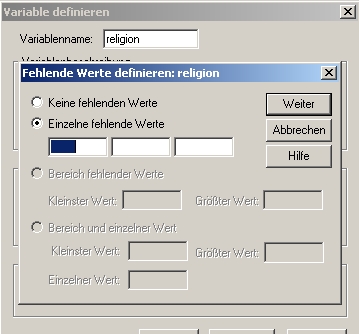

SPSS erlaubt, leere Felder automatisch mit bestimmten Einträgen auszufüllen oder dieselben in keinerlei Berechnungen einfließen zu lassen.

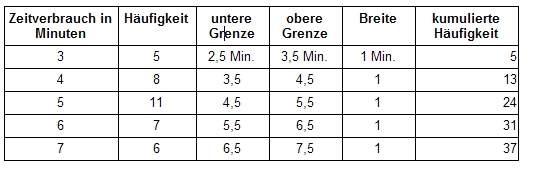

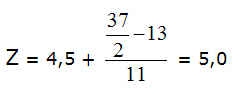

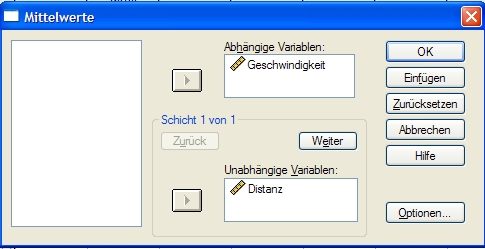

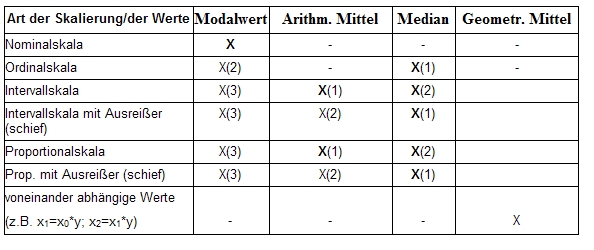

SPSS unterscheidet zwischen Systembedingt fehlenden Werten und Benutzerdefinierten fehlenden Werten. Werden z.B. Variable als numerisch definiert, werden leere Felder automatisch mit einem Komma in der Datenmatrix[1] markiert (Systembedingt). Bei Textfeldern muss ein fehlender Wert spezifisch deklariert werden (Benutzerdefinierter fehlender Wert):